CatmullRom Splines-Based Regression for Image Forgery Localization

论文(arxiv)

# 摘要

IFL(Image Forgery Location)有助于确保数字媒体取证的安全。然而,许多方法存在错误的检测(即FPs)和不准确的边界。在本文中,我们提出了基于CatmullRom样条的回归网络(CSR-Net, CatmullRom Splines-based Regression Network),它从回归的角度重新考虑IFL任务来处理这个问题。

具体来说,我们提出了一种自适应的CutmullRom样条变换方案,用于被篡改区域的粗定位。然后,对于假阳性例子,我们开发了一种新的重新评分机制,旨在筛选出不能在分类分支和实例分支上都有响应的样本。随后,为了进一步限制边界,我们设计了一个可学习的纹理提取模块,该模块通过解耦水平和垂直伪造特征来参考和增强轮廓表示,从而提取出更鲁棒的轮廓表示,从而抑制FPs。与基于分割的方法相比,由于不需要后处理,我们的方法简单而有效。大量的实验表明,CSR-Net优于现有的先进方法,不仅在标准的自然图像数据集上,而且在社交媒体数据集上。

引言

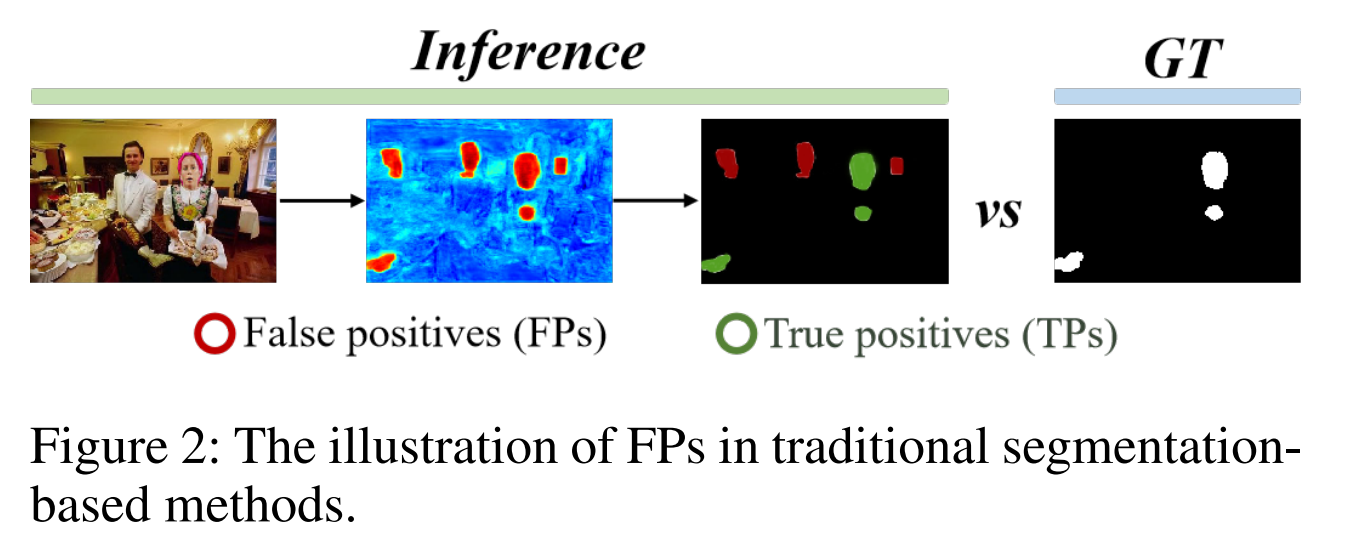

第一个问题是假阳性(FPs)。假阳性是指测试结果表明存在一个令人满意的目标区域,而实际上它并不令人信服。传统的基于分割的方法往往会出现这种情况(如图2所示)。

二值化是这些方法中不可或缺的决定性策略,它是一种直接决定前景区域块数量的阈值敏感任务。在传统的分割方法中,一个不合理的阈值往往会导致出现意外的区域(即假阳性的情况)。然而,许多方法在关注潜在的被篡改区域时,通常会忽略误报率。这对数字内容的传播有负面影响,影响了相关新闻来源的可获得性,这限制了分析结果向更有令人信服的方向发展。

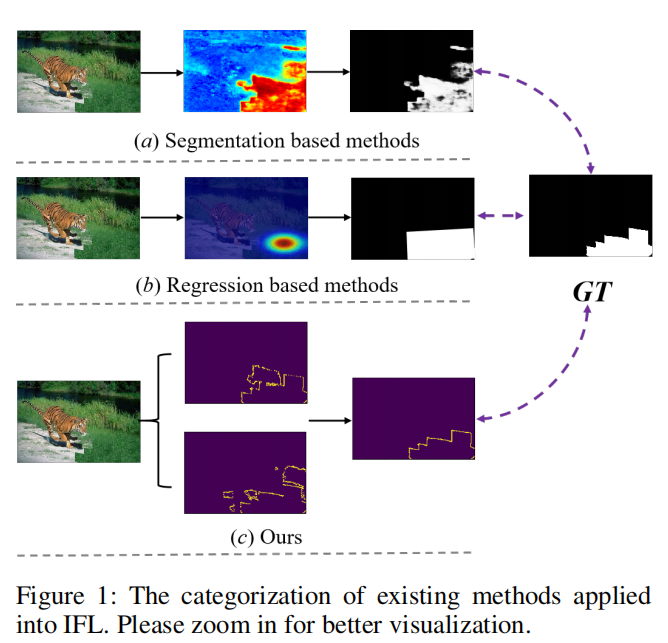

第二个问题是不准确的边界。传统的基于分割的方法存在连续解码器层之间的掩模预测不一致,导致优化目标不一致和特征空间的弱耦合(如图1a所示)。

另一方面,当直接引入一般回归方法来处理任务时,定位效果也不令人满意,因为所使用的边界盒只能以四边形的方式定位目标区域,而且通常目标区域大多出现在不规则曲线中(图1 (b)显示了旋转检测的定位效果(Li et al. 2022),其中我们使用掩蔽区域的最小边界四边形作为Ground Truth)。越来越复杂的被篡改图像提出了更大的挑战,因为大多数方法不能很好地约束或明确地建模伪造的区域边界,这很容易导致在检测结果中混合其他目标或不兼容的背景。

最近,一些基于回归的策略在目标检测领域的假阳性判定方面取得了显著进展 (You et al. 2022; Li and Kosecka 2022; Chen et al. 2023)。与目标检测任务不同,IFL是一个像素级的任务,这意味着方法迁移的直接性将带来性能下降。为此,需要引入一些定制的方法和处理方法,可以有效地连接这两个任务。

首先,对于标记为GT的掩模,我们引入了CatmullRom样条曲线来将其转换为多边形帧,从而使回归策略能够应用于像素级的任务,如IFL。同时,在训练和推理过程中,为了使多边形标记更接近真实标记,提出了自适应参数CatmullRom样条方法,该方法可以最小化预测区域与地面真实值之间的相似性差距和目标区域的曲率。其次,为了进一步、明确地抑制定位结果中的假阳性,我们提出了一种有效的重评分机制:我们通过两个独立的预测分支,直接拒绝在两个分支中都没有接收到响应的假阳性,每个预测分支都有一个区域分类得分和一个实例得分。此外,为了得到更准确的边界,我们通过解耦水平纹理特征和垂直纹理特征,进一步细化预测区域的轮廓,以建模锻造区域边界,减少它们与其他掩模之间的重叠。

我们的贡献可以概括为三类:

1)我们制作了一个基于CatmullRom样条的回归网络(CSR-Net, CatmullRom Splines-based Regression Network),首次尝试将回归方法引入像素级任务。

2)为了明确抑制假阳性样本和避免不确定性边界,我们设计两个相互互补和强化的组件,即综合再评分算法(CRA,Comprehensive Re-scoring Algorithm),综合评估每个区域的信任分数作为篡改区域,而垂直纹理交互感知(VTP, Vertical Texture-interactive Perception)控制生成更准确的区域边缘。

3)在多个公共数据集(包括自然图像数据集和社交媒体数据集)上进行的大量实验表明,我们的方法与IFL中最先进的方法相比具有优越性。

方法

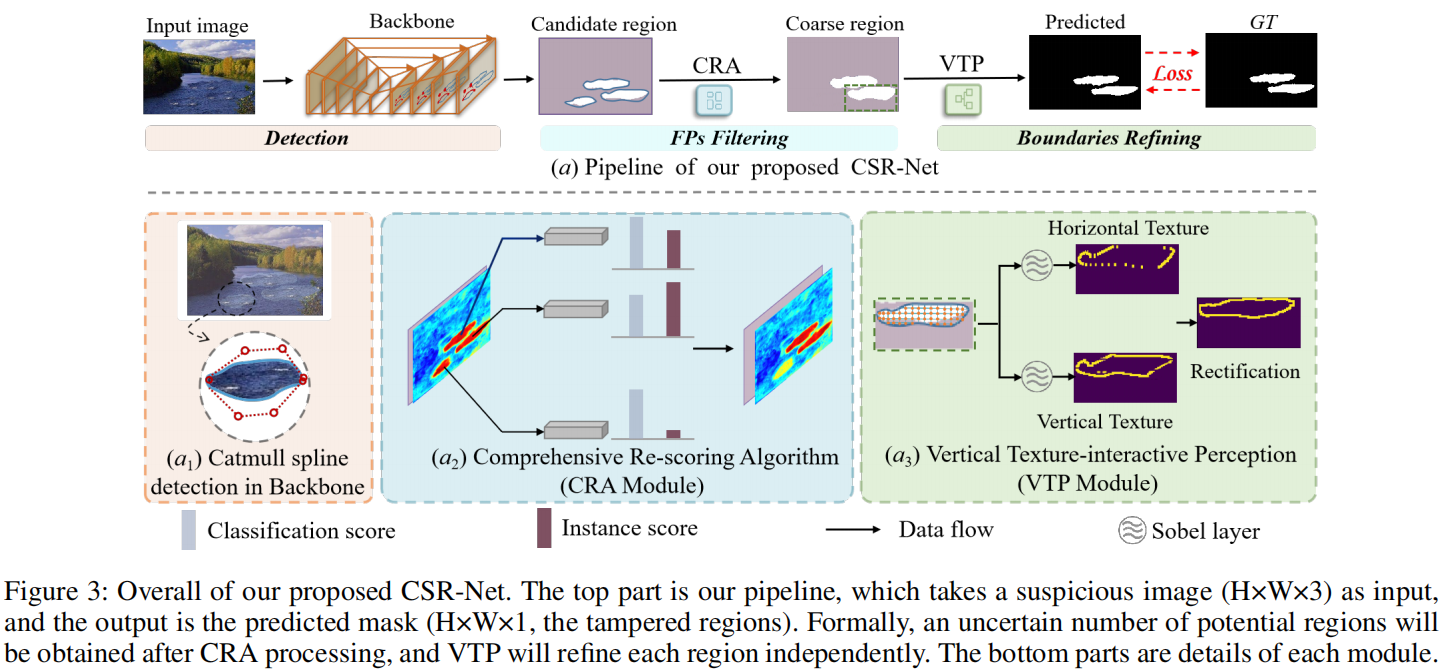

概括

图3是对我们的框架的概述。输入图像表示为 $ X R^{H×W×3} $ 。首先,我们使用嵌入ResNet-50的FPN作为骨干网络进行Catmull样条检测。

更具体的是,我们的方法利用一种基于CatmullRom样条的参数化方法来自适应地识别目标分割区域(橙色部分)。跟随(Chen

et al. 2017),我们采用空间空间金字塔池(ASPP, atrous spatial pyramid

pooling)和ResNet-50来捕获长期上下文信息和多尺度特征。

这种无锚定的卷积神经网络大大简化了我们的任务的检测,也允许我们获得一个粗糙的特征图。稍后,我们使用一个重新评分机制(CRA,re-scoring

mechanism)来筛选出在粗特征图(蓝色部分)上突出显示的可疑区域的假阳性样本。最后,我们同时从水平和垂直方向的区域进行纹理提取(by

VTP),以预期获得更准确的边界(绿色部分)。请注意,保留的每个篡改区域将由VTP独立处理。

CatmullRom样条检测

大多数传统方法在IFL中使用基于分割的思想。

然而,在处理此类面具或基于多边形的数据集时,基于回归的方法往往是一种更有效的方法,例如(Liu等2019;Pranav,正刚等2020;Zhang等2022)。

一般来说,主流的基于回归的方法需要复杂的处理来适应实例的边界,这导致了实践中的不可靠和不稳定性。近年来,样条曲线被用于计算机图形应用中生成各种形状的曲线。例如,自动驾驶车道线(Ma等2019年;余和陈2017年)、文本检测(刘等2020年;唐等2022年;阮等2021年)、故障检测(Park等2011年;郭和王2005年)等。其中,CatmullRom样条函数是一种经典的插值样条,由于其变换效应和推理代价,适用于被篡改区域的参数化(钱德拉2020;Li

2022)。

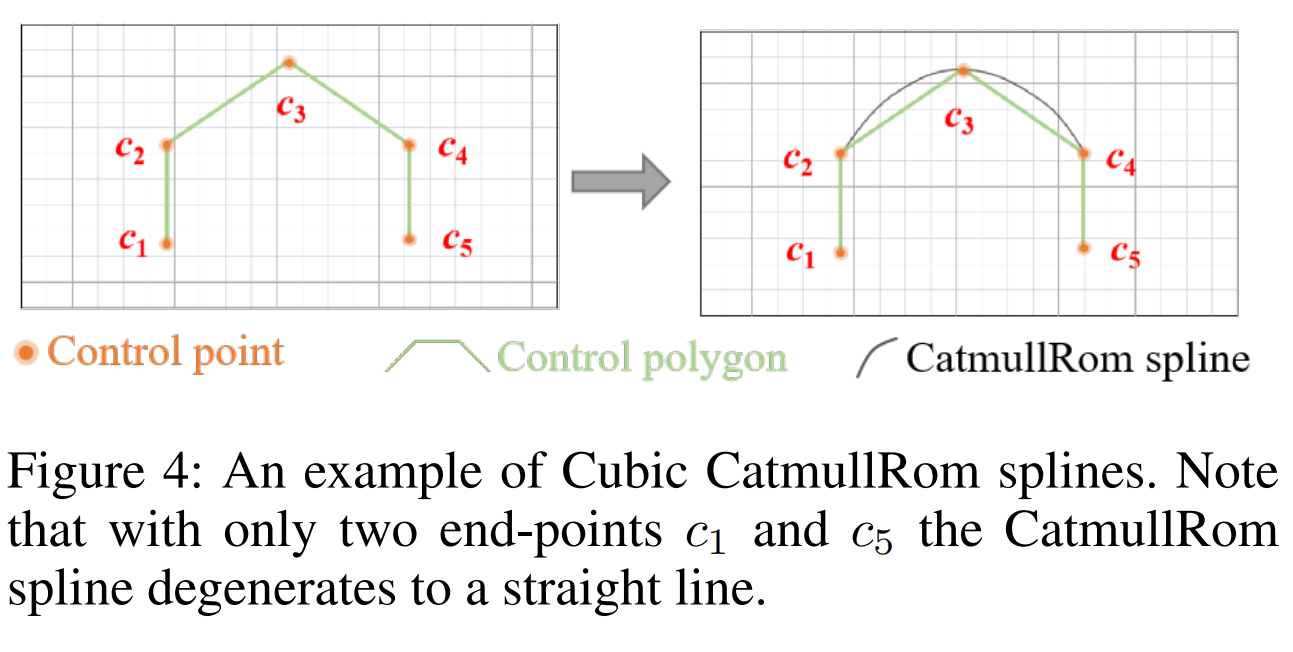

具体地说,CatmullRom样条是一组三次插值样条,因此每个点上的切线使用样条上的上一个点和下一个点计算。在给定的控制点下,卡特穆尔罗姆样条函数可以适应任何形状(李和陈2016;李,刘,刘2022)。此外,构造三次小矩阵样条函数只涉及整数系数,与其他样条函数相比,它降低了实现成本。上面提到的所有这些属性都有助于提高更快的推理速度和更低的计算消耗(Flops)。

数学上,数学样条被定义为等式

1: \[c_i(t)=\sum_{j=0}^3b_j(t)\boldsymbol{p}_{i+j},\quad

i=0,1,\ldots,n-3\]

其中,0≤t≤1,\(p_{i}(i=0,1,\ldots,n-3;n\geq3)\)为控制点,\(b_{j}(t)\) 为基。例如,它可以用等式2来表示当函数\(b_{j}(t)\)中t的最大幂为3时:

\[c_i(t)=\frac{1}{2}\cdot[1\quad t\quad t^2\quad t^3]\cdot\begin{bmatrix}0&2&0&0\\-\tau&0&\tau&0\\2\tau&\tau-6&-2(\tau-3)&-\tau\\-\tau&4-\tau&\tau-4&\tau\end{bmatrix}\cdot\begin{bmatrix}p_i\\p_{i+1}\\p_{i+2}\\p_{i+3}\end{bmatrix}\]

为了协调被篡改区域的任意形状与CatmullRom样条曲线,我们从现有的数据集和真实的图像中深入研究了定向或弯曲的被篡改区域。在卡氏样条曲线中,\(\tau\)(张力因子)是控制样条线紧性的一个重要参数。张力因子的值越高,曲线在控制点之间弯曲越紧密,从而在移动过程中更接近给定的数据点。相反,较低的张力系数值会使控制点之间的曲线更平滑。直观地看,传统的卡莫样条(参数\(\tau =1\))对IFL任务很差,因此我们试图通过调整τ在匹配精度和曲线平滑度之间找到正确的平衡。消融实验(在消融分析部分)表明,当\(\tau\)设置为16时,CatmullRom样条曲线对该任务是可靠的。它还允许学习到的控制点更接近前景(篡改)区域。

CatmullRom Ground Truth 生成

在IFL中,许多基准测试使用基于掩码或多边形的数据集作为公共数据集 (Dong, Wang, and Tan 2013; Hsu and Chang 2006; Alibaba 2021/2022)。给定曲线边界的注释点 $ { p_i } _{i=1} ^n $ ,其中 $ p_i $ 表示第 $ i $ 个注释点,主要目标是根据等式一获得CatmullRom样条 $ c(t) $ 的最优参数 。为了实现这一点,我们可以简单地应用标准最小二乘法,如等式3所示 :

\[\begin{bmatrix}p_{03t_0}&\cdots&p_{33t_0}\\p_{03t_1}&\cdots&p_{33t_1}\\\vdots&\ddots&\vdots\\p_{03t_m}&\cdots&p_{33t_m}\end{bmatrix}\begin{bmatrix}c_{x_0}&c_{y_0}\\c_{x_1}&c_{y_1}\\c_{x_2}&c_{y_2}\\c_{x_3}&c_{y_3}\end{bmatrix}=\begin{bmatrix}\mathscr{P_{x_0}}&\mathscr{P_{y_0}}\\\mathscr{P_{x_1}}&\mathscr{P_{y_1}}\\\mathscr{P_{x_2}}&\mathscr{P_{y_2}}\\\mathscr{P_{x_3}}&\mathscr{P_{y_3}}\end{bmatrix}\]

其中,m表示一个曲线边界的标注点的数量。而t是通过使用累积长度与多段线的周长的比值来计算的。 $ p_{ij} $ 可以从等式中引用1,我们使用 $ _{i} $ 表示变换后的新坐标点。根据等式1和等式3,我们将原始的掩码注释转换为一个参数化的CatmullRom样条曲线。

图4:立方CatmullRom样条曲线的一个例子。请注意,由于只有两个端点c1和c5,CatmullRom样条线就会退化为一条直线。

综合再评分算法CRA

Mask

R-CNN背后的基本机制是将所得到的边界框的分类一致性视为分数,然后使用一个预先确定的阈值来筛选出背景框。然而,尽管有了一些进展,当边界框包含一个明显不兼容的区域实例时,它伴随着大量的背景信息,并且Mask

RCNN经常显示出如此低分数的真阳性,而它保留了一些相对较高可信度的FPs。因此,我们为每个区域实例重新分配分数。具体来说,区域实例的综合得分由分类得分(CLS)和实例得分(INS)两部分组成。数学上,给定预测的n类分数

$~ \mathrm{CLS}=\{s_{ij}^{cls}\mid j\in[0,\cdots,n-1]\} $ 和 $~

\mathrm{INS}=\{s_{ij}^{ins}\mid j\in[0,\cdots,n-1]\} $

通过等式4计算第i个提出建议的综合得分: \[s_{ij}=\frac{e^{s_{ij}^{cls}+s_{ij}^{ins}}}{\sum_{l=0}^{n-1}e^{s_{il}^{cls}+s_{il}^{ins}}}\]

在我们的工作中,我们采用了n =

2,其中这两个类再现了图4:三次组合样条的一个例子。请注意,由于只有两个端点c1和c5,CatmullRom样条线就会退化为一条直线。发送篡改(前景)和真实(背景)区域。因此,我们只需要计算前景类的分数。

CLS由一个类似于Mask

R-CNN的分类分支直接获得,INS是区域实例在全局区域分割图上的激活值。具体来说,它被投影到每个区域实例的篡改区域分割地图上,包含\(P_{i} = \{p_{i}^{1},p_{i}^{2}\ldots p_{i}^{n}

\}\),并且区域实例区域中Pi的平均值可以表示为: \[s_{i1}^{ins}=\frac{\sum_jp_i^j}N\]

其中,Pi是区域分割地图上第i个区域实例的像素值的集合。将分类得分与实例得分有机结合,得到综合得分,在实践中可以降低FP的可信度。这是因为FPs往往比分割图上的区域有更弱的响应。

下面的实验结果表明,我们的设计对图片剪切情况更友好,因为剪接情况通常在分割图上享有更强的响应,较高的实例分数将弥补较低的分类分数。

垂直纹理-交互式感知VTP

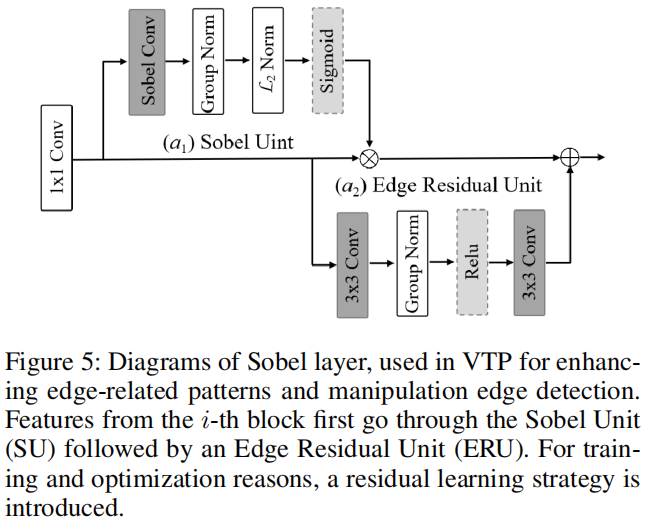

传统的边缘检测操作符(例如,索贝尔、罗伯茨、普雷威特等)有助于提取自然图像处理任务中手工制作的特征,而最大的缺点是它们不能根据任务的特殊性进行动态学习。受(Holla和Lee 2022)的启发,我们在一个被称为Sobel层的可学习模块中采用了一个边缘检测算子,见图5。

图5:Sobel层图,用于VTP,用于增强边缘相关模式和操作边缘检测。来自第i个块首先通过Sobel单元(SU),然后通过一个边缘剩余单元(ERU)。为了进行训练和优化的原因,引入了一种残差学习策略。

此外,为了更好地建模被篡改的区域边界,我们在我们的网络中引入了垂直纹理交互式感知(VTP,

Vertical Texture interactive

Perception)。在VTP中,被篡改的区域用一组等高线点表示,这些包含强纹理特征的点可以精确地定位具有任意形状的被篡改区域。

看到它们:有两个核心并行分支在VTP分支,在顶部,我们引入一个卷积内核大小1×k滑动功能地图模型局部纹理信息在水平方向,只关注k-range地区的纹理特征。这个巧妙的技巧通过我们的预实验证明是简单且有效的。此外,它几乎是免资源开销的同时保持竞争效率。通过类似的范例,将底部分支通过大小为k×1的卷积核在垂直方向上对纹理特征进行建模。k是控制纹理特征接受场大小的超参数。在实际实验中,我们取k

=

3。最后,涉及两个独立的s型层,将两个方向上的热图归一化为[0,1]。这样,就可以在两个正交方向上检测到篡改区域,并在两个不同的热图中用等高线点表示,其中任何一个热图都只响应特定方向上的纹理特征。

由于在两个正交方向上考虑响应值可以有效地抑制假阳性预测,因此通过点重评分算法进一步处理来自VTP的两个热图。具体地说,通过NMS对不同热图中的点进行直接处理,以实现紧密的表示。然后,为了抑制具有强单向或弱正交响应的预测,我们只选择在两个热图中具有不同响应的点作为候选点。最后,篡改区域可以用由这些高质量轮廓点组成的多边形表示。

最优化

如上所述,我们的网络包括多任务任务。因此,我们计算了以下组件的损失函数:

\[L=L_{rpn}+\lambda_{1}\cdot

L_{cls}+\lambda_{2}\cdot L_{mask}+\lambda_{3}\cdot

L_{qts}+\lambda_{4}\cdot L_{CR}\]

其中,Lrpn、Lcls和Lmask是来自Mask

R-CNN的标准损失。Lgts用于优化篡改区域检测,定义为: \[L_{gts}=\frac{1}{N}\sum_i-\log\left(\frac{e^{p_i}}{\sum_je^{p_j}}\right)\]

Lgts是Softmax损失,其中p是网络的输出预测。

LCR用于优化CatmullRom样条检测的ft,定义为:

\[L_{CR}=L_{ctr}+L_{bias}\]

Lctr和Lbias均为FCOS损失(Tian等人,2019年)。前者用于优化从CatmullRom控制点中心的距离损失,而这些控制点到中心的偏移距离受后者的限制。

实验

实验设置

预训练数据

我们创建了一个规模可观的图像篡改数据集,并使用它来预训练我们的模型。

该数据集包括三类:1)拼接,2)复制移动,和3)删除。

测试数据集

如下(Wang等2022;胡等2020),我们在 CASIA (Dong, Wang, and Tan 2013), Columbia (Hsu and Chang 2006), NIST16(Guan et al. 2019), COVER (Wen et al. 2016)上评估我们的模型。

评价指标

为了量化定位性能,根据之前的工作(Hu et al. 2020),我们在操作掩模上使用像素级的曲线下面积(AUC)和F1分数。由于计算f1分数需要二进制掩码,因此我们采用相等错误率(EER)阈值来对它们进行二值化。

实施细节

输入图像的大小被调整为512×512。在这项工作中,骨干网络是ResNet- 50,在ImageNet上进行了预训练。由PyTorch实现,我们的模型使用GeForce GTX 3090进行训练,使用Adam作为优化器。

与SOTA方法的比较

遵循经典方法(Hu et al. 2020;Wang et al. 2022),我们的模型与其他最先进的篡改定位方法在两种设置下进行了比较: 1)训练合成数据集和评估完整的测试数据集,2)调整预训练模型对测试数据集的训练分割和评估它们的测试分割。预先训练的模型将演示每种方法的通用性,fne调整模型将演示一旦域差异显著减少,每种方法在局部的表现如何。

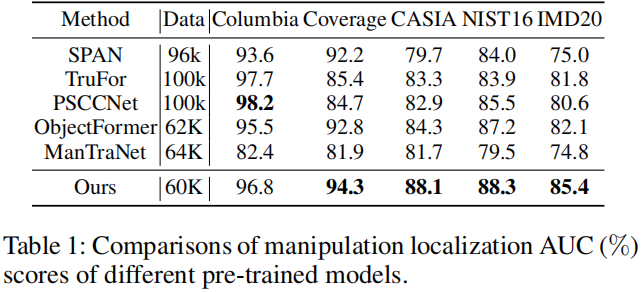

预训练模型

表1显示了不同SOTA方法的预训练模型在像素级AUC下的fve数据集上的定位性能。

我们的CSR-Net在Coverage、CASIA、NIST16和IMD20上取得了最好的定位性能,在Columbia排名第二。特别是在复制-移动数据集(COVER)上达到了94.4%,其图像伪造区域与背景难以区分。这验证了我们的模型具有抑制FPs和生成更准确的边缘的优越能力。然而,我们未能在Columbia上取得最好的表现,AUC得分比PSCCNet低1.4 %。我们推测,原因可能是他们(PSCCNet)合成的训练数据的分布与Columbia数据集非常相似。表2中的结果进一步支持了这一点,这说明CSR-Net在AUC和F1得分上都优于PSCCNet。此外,值得指出的是,我们在较少的预训练数据下取得了不错的结果。

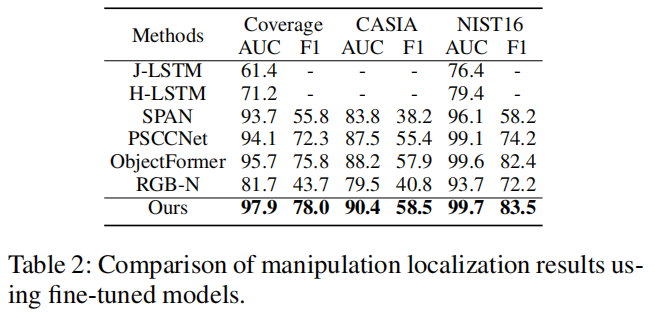

微调模型

预训练模型的网络权值用于启动调优模型,这些模型将分别在Coverage、CASIA和NIST16数据集的训练部分上进行训练。我们在表2中评估了不同方法的微调模型。

对于AUC和F1,我们的模型取得了显著的性能提高。这表明CRA模块有效地抑制了假阳性错误实例,提高了VTP预测区域位置和边界的准确性。

在综合表1和 表2中的数据后,我们的方法证明了为像素级任务引入回归方法是有效的,这是在引言中提到的。

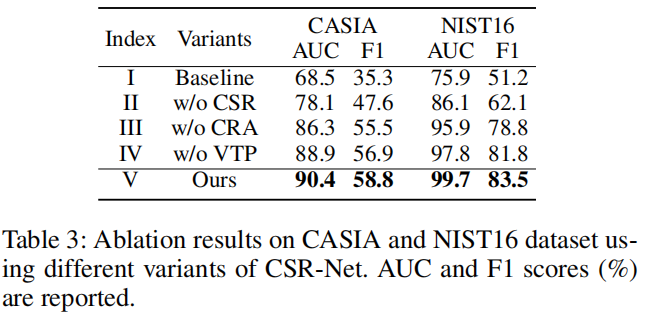

消融分析

在本节中,我们将进行实验来证明我们所提出的CSR-Net方法的有效性。与传统的回归方法相比,正式引入了基于CatmullRom样条的回归(CSR)来更好地描述被篡改的区域。综合评分算法(CRA)的目标是选择分类得分高、实例得分高的期望区域,而垂直纹理交互感知(VTP)则采用水平和垂直两种方式对纹理特征进行建模,以参考目标区域。为了进一步评估CSR、CRA和VTP的有效性,我们分别删除它们,并验证它们在CASIA和NIST16数据集上的伪造定位性能。表3显示定量结果。

基线(I)表示我们只使用传统的回归方法(Li et al.

2022)。在接下来的消融实验中,我们可以推断,当不涉及VTP时,CASIA的F1评分下降了1.9

%,NIST16的评分下降了1.7

%。而在没有CRA时,AUC评分比(IV)下降更多。然而,当CRA不可用时,在(II)中可以观察到明显的性能下降,即AUC为12.3%,F1为11.2%。

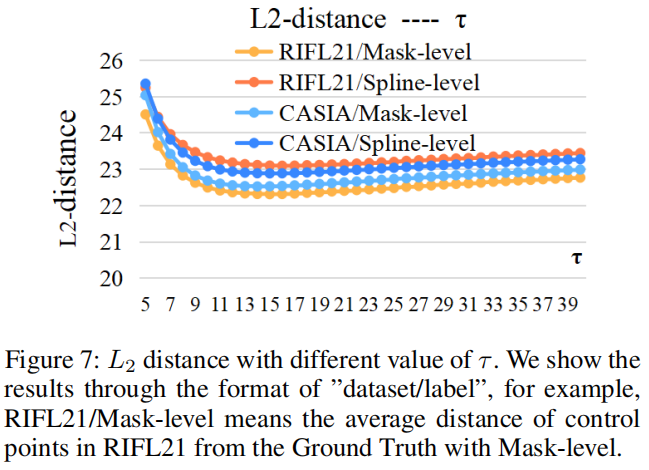

在图7中,我们展示了CatmullRom

Ground Truth生成中参数\(\tau\)的不同值,以验证对自然图像数据集(即CASIA)和社交媒体数据集(即RIFL21)的各自预测效果。

直观地看,随着\(\tau\)的逐渐增加,不在不同数据集中,拟合的CatmullRom控制点与具有掩模水平的地面真值之间的欧几里德距离逐渐减小,显示出更好的拟合。然而,当\(\tau\)超过16时,欧氏距离反而呈现出扩张的趋势,这意味着拟合效果可能会减少。显然,\(\tau =16\)是生成基于CatmullRom的最佳Ground Truth的最好选择。

可视化结果

定性结果

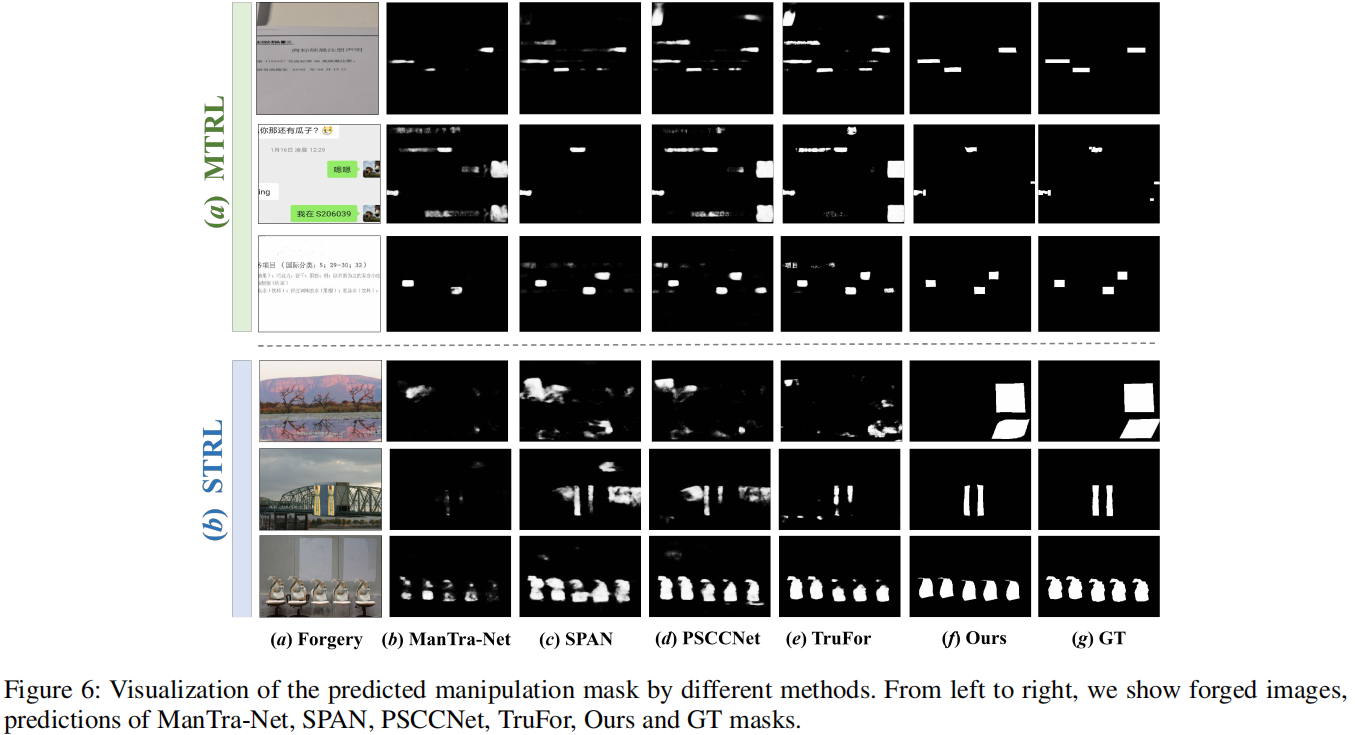

我们在图6中提供了不同方法的预测伪造掩模。

图6:通过不同的方法可视化预测的操作掩模。从左到右,我们展示了伪造的图像,对ManTra-Net、SPAN、PSCCNet、TruFor、我们的预测和GT掩模。

由于 ObjectFormer(Wang et al. 2022)的源代码不可用,因此他们的预测不可用。与最先进的方法相比,我们的CSR-Net在抑制假阳性方面取得了更好的性能,无论是在抑制还是在更准确的篡改区域边界方面。我们有理由相信,改善受益于CRA和VTP。CRA能够更全面地考虑每个可能的区域,确定被篡改区域和真实区域之间的细微差别,而VTP同时通过两种正交方法建模纹理边界,以准确描述目标区域。

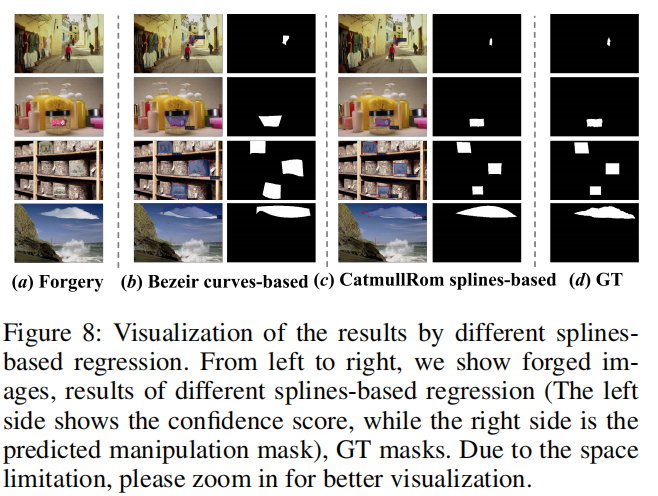

不同的基于样条曲线的回归

有许多类型的插值函数,经典的CatmullRom样条和贝塞尔曲线,前者是一个插值样条函数,精确插值一组已知数据点通过使用一系列的节点,而后者是一个近似样条函数,近似一组数据点使用节点。IFL的数据集来自自然图像和社交媒体,被篡改的区域共享不同的形状。通过比较实验,我们发现CutmullRom样条更适合于具有不同曲率的数据集(如IFL),而基于贝塞尔曲线的方法有时容易受到其他目标的干扰。详情请参见图8。

图8:通过不同的回归可视化结果。从左到右,我们展示了伪造的图像,不同的基于样条曲线的回归结果(左边显示了信任分数,而右边是预测的操作掩模),GT掩模。由于空间限制,请放大以更好地可视化。

结论

在本文中,我们精心设计了一个定制的基于CatmullRom样条的回归网络(CSR-Net),并尝试将回归方法引入像素级图像篡改定位(本文中的IFL)。详细地说,与传统的边界盒检测方法相比,我们引入了CatmullRom定位技术,该技术对目标区域控制点的轮廓进行了建模,从而实现了更准确和有效的篡改区域定位。然后,为了抑制FPs(假阳性),设计了综合再评分算法(CRA),以分类评分和实例评分来区分精确的篡改区域。此外,我们还提出了一个可学习的区域纹理提取模块垂直纹理交互感知(VTP)来进一步参考边缘。因此,CSRNet可以在不接近FPs的情况下感知所有被篡改的区域,并实现准确的定位。大量的实验表明,CSR-Net优于现有的最先进的方法,不仅在自然图像数据集上,而且在社交媒体数据集上。