Deep Clustering:A Comprehensive Survey

摘要

聚类分析在机器学习和数据挖掘中起着不可或缺的作用。学习一个好的数据表示对聚类算法至关重要。近年来,深度聚类(DC,deep clustering)可以利用深度神经网络(DNNs,deep neural networks)学习聚类友好表示,已广泛应用于聚类任务。现有的DC总结主要集中在单视图场和网络架构上,忽略了复杂的集群应用场景。为了解决这个问题,在本文中,我们提供了一个对DC的数据源的全面总结。对于不同的数据源,我们从方法学、先验知识和体系结构等方面系统地区分了聚类方法。具体地说,DC方法被分为四类,传统的单视图DC、半监督DC、深度多视图聚类(MVC)和深度传输聚类。最后,我们讨论了DC不同领域的开放挑战和潜在的未来机遇。

索引术语——深度聚类(DC)、多视图聚类(MVC)、半监督聚类、迁移学习。

发表于人工智能领域B区期刊TNNLS,

I. 引言

随着网络媒体的发展,可以很容易地收集大量复杂的数据。通过对这些数据的精确分析,我们可以挖掘出这些结论的价值,并应用于许多领域,如人脸识别[1]、[2]、情绪分析[3]、[4]和智能制造[5]、[6]。

一个可以用于对具有不同标签的数据进行分类的模型是许多应用程序的基础。对于有标记的数据,允许将标签作为最重要的信息作为指南。对于未标记的数据,找到一个可量化的目标作为模型构建过程的指导是聚类的关键问题。在过去的几十年里,人们提出了大量基于浅模型的聚类方法,包括基于质心的聚类基于密度的聚类[9],[10],[11],[12],[13],分布的聚类[14]、层次聚类[15]、集成聚类[16],[17],和多视图聚类(MVC)[18],[19],[20],[21],[22],[23],[24],[25],[26],[27],[28],[29],[30]。这些浅层模型只有在特征具有代表性时才有效,而由于特征学习能力较差,它们在复杂数据上的性能通常受到限制。

为了将原始复杂数据映射到一个易于聚类的特征空间,许多聚类方法都侧重于特征提取或特征转换,如主成分分析(PCA)[31]、核方法[32]、光谱方法[33]和深度神经网络(DNN)[34]。在这些方法中,DNN由于其优秀的非线性映射能力和在不同场景下的灵活性,是一种很有前途的方法。一种设计良好的基于深度学习的聚类方法[称为深度聚类(DC)],旨在有效地从数据中提取更有利于聚类的特征,并同时使用学习到的特征进行聚类。与传统的聚类方法不同,DC背后的基本概念是将聚类目标合并到深度学习提供的鲁棒表示能力中。因此,获取一个重要的数据表示成为DC的基本要求。

DC领域的研究很多,也有一些关于DC[35]、[36]、[37]、[38]方法的总结。具体来说,现有的DC系统综述主要集中在单视图聚类任务和神经网络的架构上。例如,Aljalbout等人。[35]只关注基于深度自动编码器(DAE)的深度单视图聚类方法。Min等人从不同深度网络的角度对DC方法进行分类。Nutakki等人[37]根据其训练策略将深度单视图聚类方法分为三类:多步连续DC、联合DC和闭环多步DC。Zhou等[38]通过特征学习与聚类模块的交互方式对深度单视图聚类方法进行分类。然而,在现实世界中,聚类的数据集总是相关的,例如,阅读的品味与对电影的品味相关,而来自同一个人的侧面和满脸应该被贴上相同的标签。对于这些数据,基于半监督学习、多视图学习和迁移学习的DC方法也取得了重大进展。不幸的是,现有的评论并没有过多地讨论它们。

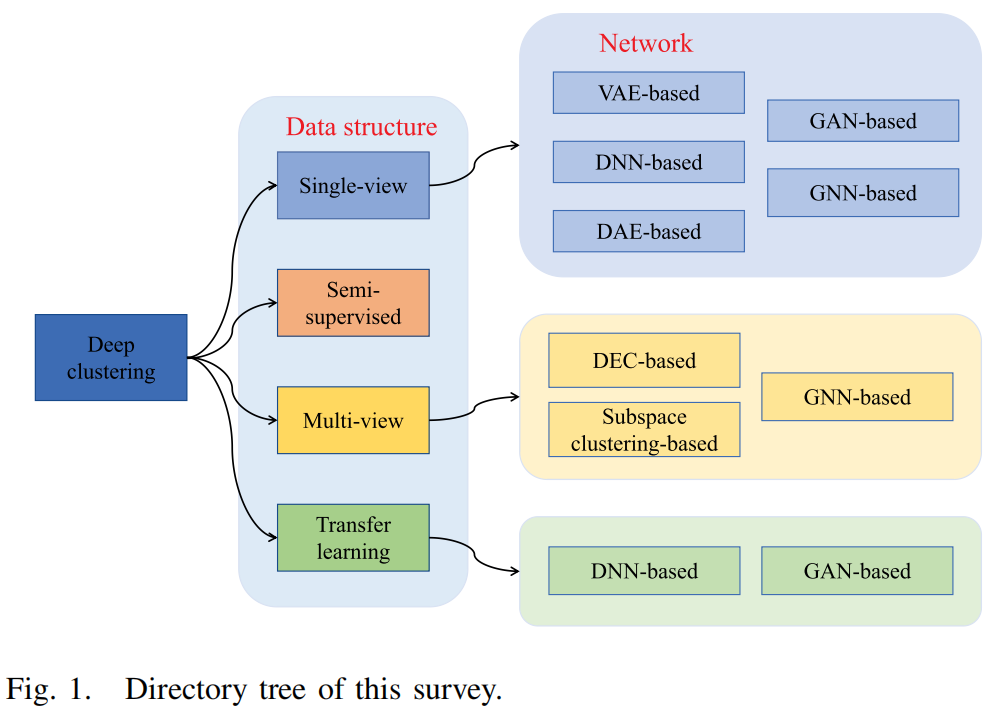

因此,从数据源的角度来对DC进行分类是很重要的。在本总结中,我们从数据的初始设置结合深度学习方法的角度总结了DC。我们从网络和数据结构的角度介绍了DC技术的最新进展,如图1所示。

具体来说,我们将DC方法组织为以下四类。由于我们从数据源的角度来划分方法,所以特定方法的实现并没有完全分离。方法中有一部分在内部相互关联因此,从数据源的角度来对DC进行分类是很重要的。在本总结中,我们从数据的初始设置结合深度学习方法的角度总结了DC。我们从网络和数据结构的角度介绍了DC技术的最新进展,如图1所示。具体来说,我们将DC方法组织为以下四类。由于我们从数据源的角度来划分方法,所以特定方法的实现并没有完全分离。方法中有一部分在内部相互关联。

1)深度单视图聚类:对于传统的聚类任务,通常假设数据具有相同的形式和结构,称为单视图或单模态数据。用

DNNs提取这些数据的表示是DC的一个重要特征。然而,更值得注意的是不同的应用深度学习技术,它们与DNNs的结构高度相关。为了比较特定DNNs的技术路线,我们将这些算法分为五类:基于DAE的DC、基于DNN的DC、基于变分自编码器(VAE,variational

autoencoder)的DC、基于生成对抗网络(GAN,generative adversarial

network)的DC和基于图神经网络(GNN,graph neural

network)的DC。

2)基于半监督学习的DC:当待处理的数据包含一小部分先验约束时,传统的聚类方法不能有效地利用这些先验信息,而半监督聚类是解决这一问题的有效方法。目前,深度半监督聚类的研究还没有得到很好的探索。然而,半监督聚类是不可避免的,因为通过在模型中添加附加信息作为约束损失,使聚类方法成为半监督聚类方法是可行的。

3)基于多视角学习的DC:在现实世界中,数据通常来自不同的特征收集器或具有不同的结构。我们称这些数据为“多视图数据”或“多模态数据”,其中每个样本都有多个表示。基于多视图学习的DC的目的是利用多视图数据中包含的一致性和互补的信息来提高聚类性能。此外,多视图学习的思想可能对深度单视图聚类具有指导意义。在本总结中,我们将深度MVC分为三类:基于深度嵌入式聚类(DEC,deep-embedded

clustering)、基于子空间聚类和基于GNN。

4)基于迁移学习的DC:对于一个实例数量有限和高维度的任务,有时我们可以找到一个助手来提供额外的信息。例如,如果任务A与另一个任务B相似,并且任务B比A有更多的聚类信息(B被标记或B比A更容易聚类),那么将信息从B转移到A是有用的。无监督领域自适应(UDA,unsupervised

domain

adaption)的迁移学习近年来得到了广泛的发展,它包含两个领域:带有标签的源域和未标记的目标域。迁移学习的目标是将从源任务中学习到的知识或模式应用到一个不同但相关的目标任务中。基于迁移学习的DC分算方法旨在利用相关任务的信息来提高当前聚类任务的性能。

在研究相应的聚类方法之前,有必要注意聚类数据的不同特征和条件。在本总结中,现有的DC方法从数据源进行系统分类。分析了不同聚类方法的优缺点和适用条件。最后,我们提出了在DC领域的一些有趣的研究方向。

II. 定义和初步工作

我们将在本节中介绍这些符号。在本文中,我们使用大写字母来表示矩阵,并使用小写字母来表示向量。除非另有说明,本文中使用的符号将在命名法中进行总结。

本总结将介绍基于不同背景条件的四种DC问题。在这里,我们正式地定义了这些问题。给定一组数据样本\(X\),我们的目标是找到一个映射函数\(F\),它可以将\(X\)映射到\(k\)个簇中。映射结果用\(\hat

Y\)表示。因此,我们所处理的任务如下:

1)深度单视图集群:

\[F(X)\to\hat{Y}.\]

2)半监督的深度聚类: \[F(X,A)\to\hat{Y}.\]

其中A是一个约束矩阵。

3)深度MVC: \[F\left(X^1,\ldots,X^v\right)\to\hat{Y}\] 其中\(X^i\)是\(X\)的第一个视图。

4)具有域自适应的深度聚类: \[F(X^s,Y^s,X^t)\to\hat{Y}\] 其中\((X^s,Y^s)\)为已标记的源域,\(X^t\)为未标记的目标域。

III. 深度单视图聚类

表示学习[39]理论显示了特征学习(或表示学习)在机器学习任务中的重要性。然而,深度表示学习主要是监督学习,需要许多标记数据。正如我们之前提到的,DC问题的障碍是什么可以用来指导训练过程,如监督问题中的标签。DC中最“受监督”的信息是数据本身。因此,我们如何训练一个有效的特征提取器来获得良好的表示呢?根据特征提取器的训练方式,我们将深度单视图聚类算法分为五类:基于DAE、基于DNN、基于VAE、基于GAN和基于GNN。

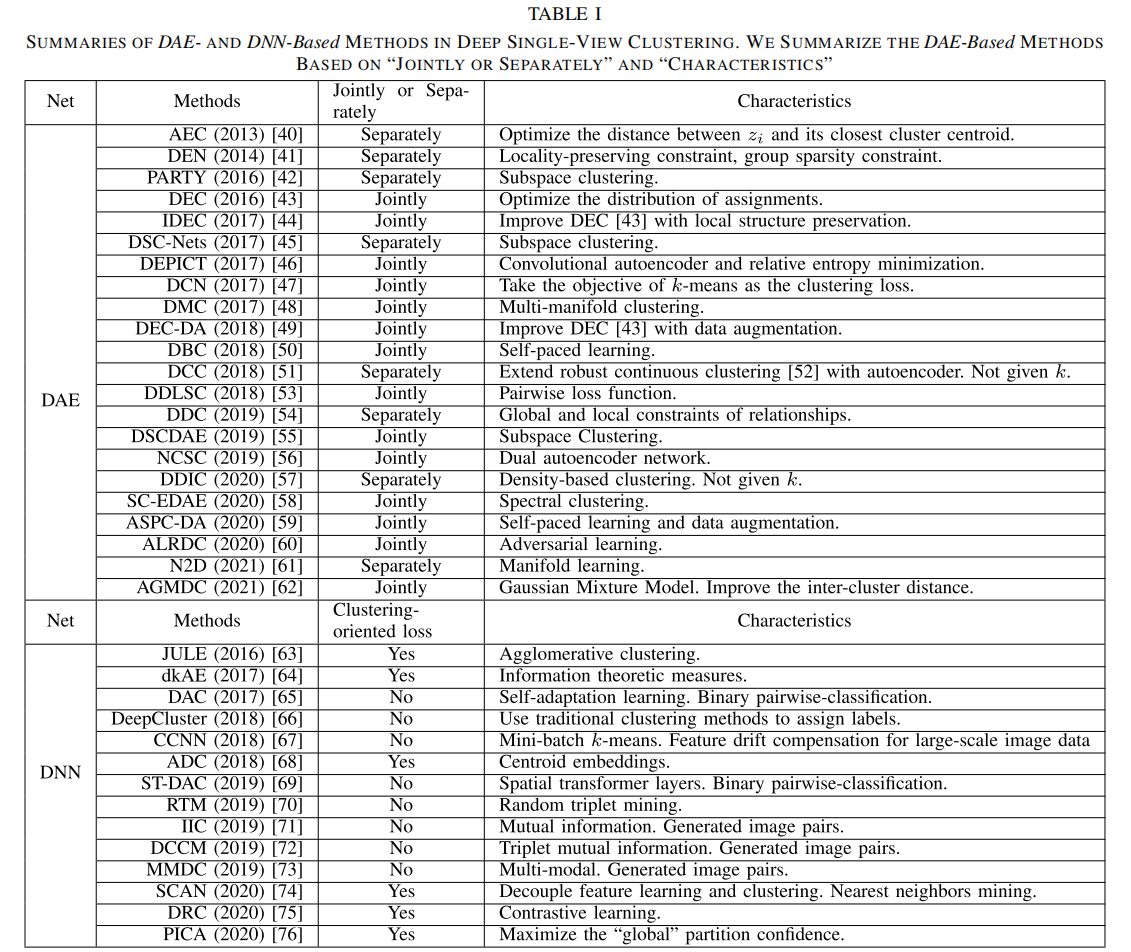

表1 基于DAE和基于DNN的方法在深度单视图聚类中的总结。我们总结了基于“联合或单独”和“特征”的基于DAE的方法

这些方法的区别主要是关于损失分量的,其中损失项的定义见表一,并解释如下。

1)DAE-Based/GNN-Based: \(L=L_{rec}+L_c\)

2)DNN-Based: \(L = L_{ext} + L_c\)

3)VAE-Based:

\(L = L_{ELBO} + L_c\)

4)GAN-Based: \(L = L_{gan} +

L_c\)

在无监督学习中,我们要处理的问题是训练一个可靠的没有标签的特征提取器。在现有的工程中,主要有两种方式:

1)根据以下原理优化伪标签的损失函数:缩小簇内距离,扩大簇间距离

2)一个可以帮助训练特征提取器的额外任务。

对于具有特殊特征提取器的聚类方法,如自动编码器,重构损失\(L_{rec}\)可以解释为额外的任务。在本文中,面向聚类的损失\(L_c\)表示聚类目标的损失。基于DAE/基于GNN的方法使用自动编码器/图自编码器作为特征提取器,因此损失函数总是由一个重构损失\(L_{rec}\)和另一个面向聚类的损失\(L_c\)组成。相比之下,基于DNN的方法使用额外的任务或其他策略来优化特征提取器。基于VAE的方法优化了证据损失下界(ELBO,evidence

lower bound)\(L_{ELBO}\)。基于GAN的方法是基于生成式的对抗性损失\(L_{gan}\)。基于这五个维度,现有的深度单视图聚类方法总结在表一和表二中。

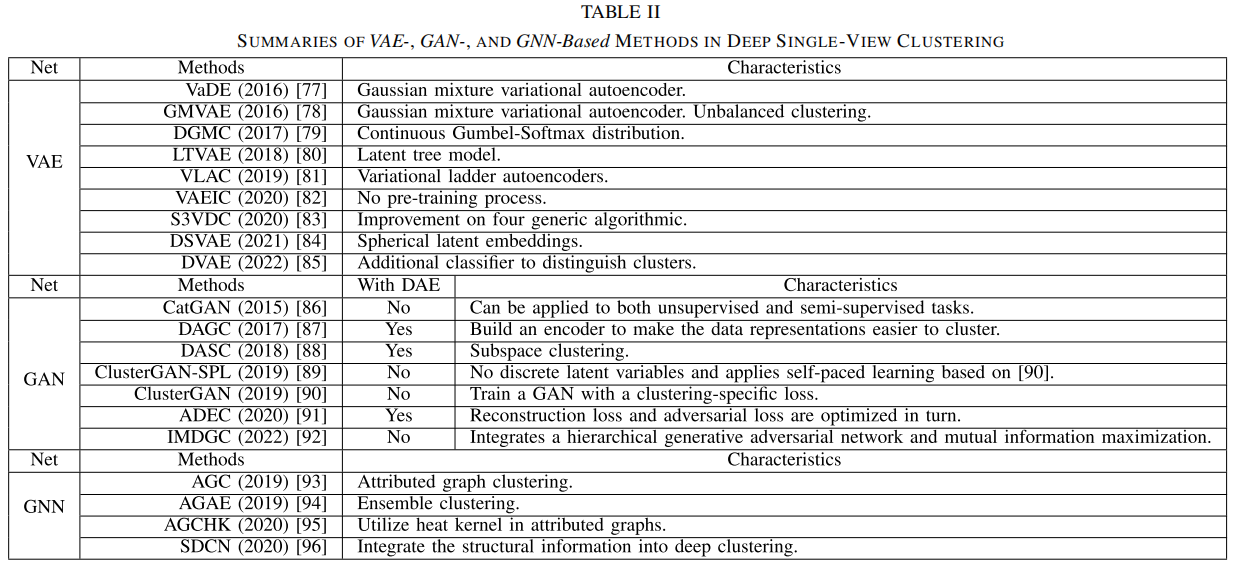

表2 基于VAE、基于GAN和基于GNN的方法在深度单视图聚类中的总结

A. 基于DAE

自动编码器网络[39]最初是为数据的无监督表示学习而设计的,可以学习一个高度非线性的映射函数。使用DAE

[97]是开发DC方法的一种常见方法。DAE的目的是通过最小化网络的重构损失来学习低维嵌入特征空间,其定义为:

\[L_{\mathrm{rec}}=\min\frac{1}{n}\sum_{i=1}^n\|x_i-\phi_r(\phi_e(x_i))\|^2\]

其中,\(\phi_e(\cdot)\)和\(\phi_r(\cdot)\)分别表示自动编码器的编码器网络和解码器网络。利用该编码器作为特征提取器,提出了各种聚类目标函数。我们将这些基于DAE的聚类方法总结为基于DAE的DC。在基于DAE的DC方法中,主要有两种获取标签的方法。第一种方法是将数据嵌入到低维特征中,然后用传统的聚类方法如k-means算法[7]等聚类方法对嵌入的特征进行聚类。第二种方法是联合优化特征提取器和聚类结果。我们将这两种方法称为“单独分析”和“联合分析”,并在下面对它们进行详细阐述。

“单独分析”是指学习特征和聚类数据被单独执行。为了解决通过“单独分析”学习到的表征由于其固有的特性而不具有聚类导向的问题,Huang等人[41]提出了一种用于聚类的深度嵌入网络(DEN,deep

embedding

network),该网络基于DAE目标施加了两个约束:局部性保留约束和群稀疏性约束。

- 局部保留约束使同一集群中嵌入的特征相似。

- 群稀疏性约束的目的是对角线化表示的相似度矩阵。

这两个约束条件提高了聚类性能,同时减少了簇内距离,扩大了簇间距离。大多数基于DAE的聚类方法的目标都是研究这两种距离。因此,在表一中,我们从“特征”的角度对这些方法进行了总结,说明了优化簇内距离和簇间距离的方法。

Peng等[42]在子空间聚类领域提出了一种新的基于深度学习的框架,即具有稀疏先验(PARTY,deep

subspace clustering with sparsity

prior)的深度子空间聚类。PARTY通过考虑不同样本之间的关系(即结构先验)来增强自动编码器并解决了传统的子空间聚类方法的局限性。据我们所知,PARTY是第一个基于深度学习的子空间聚类方法,也是第一个在神经网络之前引入全局结构进行无监督学习的工作。与PARTY不同,Ji

et al.

[45]提出了另一种深度子空间聚类网络(DSC-Net)架构来学习非线性映射,并引入了一个自表达层来直接学习相似度矩阵。

基于密度的聚类[9],[98]是另一种流行的聚类方法。Ren等人[57]提出了基于深度密度的图像聚类(DDIC,density-based

image

clustering),该方法使用DAE学习低维特征表示,然后对学习到的特征进行基于密度的聚类。特别是,DDIC不需要提前知道集群的数量。

“联合分析”的目的是学习一种更适合聚类的表示,这不同于深度学习和聚类单独进行的单独分析方法,并且神经网络在学习数据特征时没有面向聚类的目标。大多数后续的DC研究将聚类目标与特征学习相结合,使神经网络能够从数据的潜在分布中学习有利于聚类的特征。在本总结中,这些方法被总结为“联合分析”。

受非参数算法t分布随机邻域嵌入(t-SNE,t-distributed

stochastic neighbor

embedding)[99]的启发,Xie等[43]提出了一个联合框架来优化特征学习和聚类目标,命名为DEC。DEC首先通过\(L_{rec}\)学习从数据空间到较低维特征空间的映射,然后迭代优化聚类损失KL(S∥R)(即Kullback–Leibler

(KL)散度)。这里,S表示描述嵌入数据与每个聚类质心之间相似性的数据的软赋值(质心用k-means初始化),R是调整后的目标分布,与S相比具有更纯粹的聚类赋值。

DEC由于其联合学习框架和计算复杂度低,是DC技术中的一种代表性方法。基于DEC,已经提出了一些变体。例如,为了保证微调阶段的局部结构,提出了改进的DEC(IDEC)方法,以联合优化加权聚类损失和自编码器的重构损失。DEC与数据增强(DEC-DA)[49]在DEC中应用了数据增强策略。Li等人[50]提出了判别增强图像聚类(DBC)来处理图像表示学习和图像聚类。DBC有一个类似于DEC的管道,但学习过程是自定节奏的[100],其中首先选择最简单的实例,并逐步扩展更复杂的样本。

在DEC中,预测的聚类任命是由学生的t-分布计算出来的。不同的是,Dizaji等人[46]提出了一种深度嵌入的正则化聚类(DEPICT,deep-embedded

regularized clustering),通过在卷积自编码器(CAE,convolutional

autoencoder)的嵌入层上叠加一个新的聚类损失。此外,DEPICT的聚类损失通过聚类分配频率的先验和层级特征重构损失函数进行正则化。Yang等人,[47]直接将k-均值的目标作为聚类损失。该模型名为DC网络(DCN),是一种联合降维和k-均值聚类方法,通过学习DAE来实现降维。Shah和Koltun

[51]提出了深度连续聚类(DCC, deep continuous

clustering),这是一种通过将自编码器集成到范例中的扩展。DCC通过联合优化已定义的数据损失、成对损失和重建损失来进行聚类学习。特别是,它不需要对集群数量的先验知识。Tzoreff.[53]等人提出了深度鉴别聚类潜在空间(DDLSC,deep

discriminative latent space for

clustering),以优化关于鉴别成对损失函数的DAE。

深度流形聚类(DMC,Deep

manifold

clustering)[48]是第一个将深度学习应用于流形聚类[101],[102]中的方法。在DMC中,训练一个由堆叠的RBMs[103]组成的自动编码器来获得转换后的表示。DMC的重构损失和聚类损失都与以往的方法不同,即通过重构一个样本及其局部邻域来定义局部保持目标。利用样本和聚类中心之间的高斯核测量的惩罚系数和距离来定义面向聚类的目标。

最近提出的基于DAE的聚类算法也利用DAE的变体来更好地学习低维特征,并通过结合传统机器学习方法的思想来提高聚类性能。例如,利用双自编码器网络(DSCDAE,dual

autoencoder

network)[55]的深度光谱聚类和通过集成DAE学习(SC-EDAE,spectral

clustering via ensemble DAE

learning)[58]的光谱聚类,目的是将光谱聚类集成到精心设计的DC自编码器中。Zhang等[56]提出了神经协同子空间聚类(NCSC,neural

collaborative subspace clustering

),它将两个置信映射建立在自编码器学习到的特征上,作为子空间聚类的监督信息。在数据增强下对的自适应自定速DC(ASPC-DA,adaptive

self-paced DC with data

augmentation)[59]中,同同时采用了自定速学习思想[100]和数据增强技术。其学习过程与DEC相同,包括两个阶段,即对自动编码器进行预训练和对编码器进行微调。

一般来说,我们注意到所采用的网络结构与要处理的数据类型有关。例如,全连接网络通常用于提取一维数据特征,而卷积神经网络(CNNs)则用于提取图像特征。上述大多数基于DAE的DC方法都可以通过全连接的自动编码器和CAE来实现,因此,它们在一定程度上适用于各种类型的数据。然而,在计算机视觉领域,有一类专注于图像聚类的直流方法。这些方法可以追溯到[104],并被总结为基于DNN的DC,因为它们通常使用CNNs来进行图像特征学习和语义聚类。

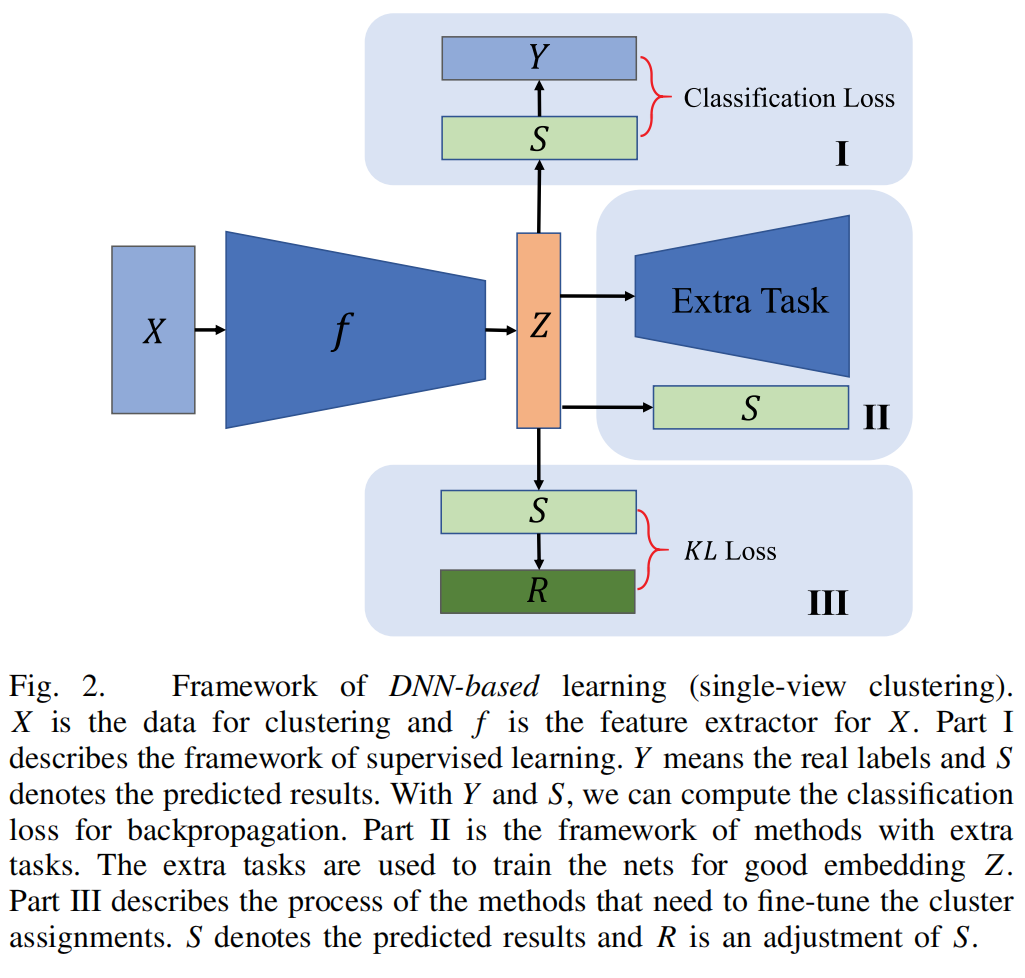

B. 基于DNN

本节将介绍基于DNN的聚类方法。与基于DAE的聚类方法不同,基于DNN的方法必须设计额外的任务来训练特征提取器。在本调查中,我们从“面向聚类的损失”和“特征”两个角度总结了表I中基于DNN的DC方法。“面向聚类的损失”显示了是否存在一个损失函数,它明确地缩小了簇内的距离或扩大了簇间的距离。图2显示了基于CNN的深度无监督学习的框架。

图2。基于DNN的学习框架(单视图聚类)。X是聚类的数据,f是X的特征提取器。第一部分描述了监督学习的框架。Y表示真实的标签,S表示预测的结果。使用Y和S,我们可以计算反向传播的分类损失。第二部分是具有额外任务的方法的框架。额外的任务用于训练网络进行良好的嵌入z。第三部分描述了需要调整集群分配的方法的过程。S表示预测结果,R为S的调整。

当DNN训练过程开始时,随机初始化的特征提取器是不可靠的。因此,基于随机初始化神经网络的DC方法通常采用传统的聚类技巧,如分层聚类[105]或专注于额外的任务,如实例生成。例如,Yang等人[63]提出了一种名为JULE的联合无监督学习方法,该方法应用凝聚聚类魔法来训练特征提取器。具体来说,JULE在一个递归框架中制定了联合学习,其中将凝聚聚类的合并操作视为前向传递,并将DNN的表示学习视为后向传递。基于这个假设,JULE还应用了一个损失,即缩小了簇内距离,同时扩大了簇内距离。在每个轮次中,JULE将两个簇合并为一个簇,并计算向后通过的损失。

Chang等人[65]提出了深度自适应图像聚类(DAC,deep

adaptive image

clustering)来解决特征学习和聚类相结合的问题。在DAC中,将聚类问题重构为二值成对分类问题,用以判断具有估计余弦相似度的成对图像是否属于同一聚类。然后,它自适应地选择相似的样本,以有监督的方式训练DNN。DAC为DC提供了一个新的视角,但它只关注于成对模式之间的关系。深度判别聚类(DDC,Deep

discriminative

clustering)分析[54]是通过引入全局和局部关系约束,更鲁棒和广义的约束。基于空间transformer的深度自适应聚类(ST-DAC,Spatial

transformer-deep adaptive clustering

)[69]应用视觉注意机制[106]来修改DAC的结构。Haeusser等人[68]提出了关联DC(ADC,associative

DC),它包含一组与图像嵌入具有相同形状的质心变量。由于质心变量在迭代过程中可以传递关于数据结构的高级信息,它们引入了一个具有多个损失项的目标函数,同时训练这些质心变量和DNN参数以及聚类映射层。

上述聚类方法通过将一个实例的聚类通过整个深度网络来估计其聚类,从而倾向于提取实例[107]的全局特征。一些聚类方法使用一个成熟的分类网络来初始化特征提取器。例如,深度集群[66]对深度模型的输出特性(如AlexNet

[108]和VGG-16 [109])应用k-means,并将集群分配作为“伪标签”来优化

CNNs的参数。Hsu和Lin [67]提出了聚类CNN(CCNN,clustering

CNN),该方法将小批量k-均值与从ImageNet数据集[110]预训练的模型集成在一起。

为了提高模型的鲁棒性,越来越多的方法对DC

[49]、[59]、[76]进行了数据增强。例如,Huang等人[76]扩展了经典的最大边际聚类[111],[112]的思想,建立了一种新的深度语义聚类方法[称为划分置信度极大化(PICA,PartItion

Confidence

mAximization)]。在PICA中,采用了颜色抖动、随机调整尺度和水平翻转三个操作来进行数据增强和扰动。

互信息也被作为学习表示[113]、[114]的标准,并在最近的聚类方法中流行起来,特别是对图像数据。各种数据增强技术已被应用于生成转换后的图像,并用于挖掘它们的互信息。例如,Ji等人[71]提出了用于语义聚类和图像分割的不变信息聚类(IIC,

invariant information

clustering)。在IIC中,每幅图像及其随机变换都被视为一个样本对。通过最大化每对聚类分配之间的互信息,该模型可以找到具有语义意义的聚类,并自然地避免退化解。深度综合相关挖掘(DCCM,deep

comprehensive correlation

mining)[72]是一种新的图像聚类框架,它使用伪标签丢失作为监督信息。此外,作者扩展了实例级互信息,并提出了三重互信息损失,以学习更多的区别特征。基于目前流行的对比学习[115],Zhong等[75]提出了深度鲁棒聚类(DRC,

deep robust

clustering),其中引入了两个对比损失项来减少类内方差和增加类间方差。互信息和对比学习是相互关联的。在

DRC,作者总结了一个框架,可以将最大化互信息转化为最小化对比损失。

在语义层次的图像聚类领域,人们认为原始图像的预测应该与数据增强后图像的预测一致。因此,在无监督学习环境下,数据增强技术不仅被用于扩展训练数据,而且可以很容易地获得有监督的信息。这就是为什么数据增强可以广泛应用于许多最近提出的图像聚类方法。例如,Nina等人[70]提出了一种具有数据增强的无解码器方法(称为随机三重态挖掘(RTM,random

triplet

mining)),用于聚类和流形学习。为了学习一个更鲁棒的编码器,该模型由三个具有共享权值的编码器组成,在概念上是一个三重网络体系结构。第一和第二编码器将数据增强生成的相似图像作为正对,第二和第三编码器采用RTM选择的负对。通常,定义三重态网络[116]的目标是为了使正对的特征更加相似,而使负对的特征更加不同。

虽然许多现有的DC方法联合学习表示和聚类,如JULE和DAC,但也有专门设计的表示学习方法[117]、[118]、[119]、[120]、[121],以自我监督的方式学习图像的视觉表示。这些方法通过训练深度网络来解决额外的任务来学习语义表示。这些任务可以是预测补丁上下文[117],在绘制补丁[118],彩色图像[119],解决拼图游戏[120],和预测旋转[121],等等。近年来,这些自监督表示学习方法已被用于图像聚类。例如,多模态DC(MMDC,multimodal

DC)[73]利用一个预测旋转的辅助任务来提高聚类性能。通过采用最近邻(SCAN,Semantic

clustering by adopting nearest

neighbors)[74]进行语义聚类,首先采用自监督表示学习方法来获得语义上有意义的高级特征。然后,它将语义上有意义的最近邻作为先验信息集成到一个可学习的聚类方法中。

由于DEC

[43]和JULE

[63]被提出联合学习DNNs的特征表示和聚类分配,许多基于DAE和基于DNN的DC方法被提出,并在聚类任务方面取得了很大的进展。然而,在聚类方法中提取的特征表示很难扩展到其他任务,如生成样本。深度生成模型最近引起了广泛的关注,因为它们可以使用神经网络来获取数据分布,从而可以生成样本(VAE

[122],GAN [123],Pixel-RNN [124],InfoGAN [125],和PPGN

[126])。其中,GAN和VAE是两种最典型的深层生成模型。近年来,研究人员将其应用于各种任务,如半监督分类[127]、[128]、[129]、[130]、聚类[131]和图像生成[132]、[133]。在III-C节和III-D节中,我们分别介绍了基于生成模型的DC算法:基于VAE的DC和基于GAN的DC。

C. 基于VAE

基于非参数聚类(DNC,nonparametric

clustering)[134]的深度学习是将深度信念网络应用于DC的先驱工作。然而,在基于概率图形模型的DC中,更多的研究来自于VAE的应用,它将变分推理和DAE结合在一起。

大多数基于VAE的DC算法旨在解决一个优化问题ELBO(见推论细节[122]和[135]),p是联合概率分布,q的近似概率分布p(z|x),x是集群的输入数据,z是对应于x而生成的潜在变量:

\[L_{\mathrm{ELBO}}=\mathbb{E}_{q(z|x)}\biggl[\log\frac{p(x,z)}{q(z|x)}\biggr].\]

不同之处在于,不同的算法有不同的潜在变量生成模型或不同的正则化器。我们列出了近年来备受关注的几种基于VAE的DC处理方法如下。为了方便起见,我们忽略了概率分布的参数化形式。

传统的VAE生成一个连续的潜在向量z,x是一个原始数据样本的向量。在聚类任务中,基于VAE的方法生成潜在向量(z,y),其中z是表示嵌入的潜在向量,y是标签。因此,优化的ELBO成为:

\[L_{\mathrm{ELBO}}=\mathbb{E}_{q(z,y|x)}\biggl[\log\frac{p(x,z,y)}{q(z,y|x)}\biggr].\]

第一个提出的无监督深度生成聚类框架是变分深度嵌入(VaDE, variational

deep embedding)[77]。VaDE使用结合VAE的高斯混合模型(GMM,Gaussian

mixture

model)[136]对数据生成过程进行建模。在该方法中,是在高斯混合先验中而不是在单个高斯先验中联合考虑簇分配和潜在变量。

与VaDE类似,高斯混合VAE(GMVAE,Gaussian

mixture

VAE)[78]是另一种将VAE与GMM相结合的DC方法。具体地说,GMVAE考虑生成模型\(p(x,z,n,c)=p(x|z)p(z|n,c)p(n)p(c)\),其中c是均匀分布的k个类别,n是正态分布。z是一个连续潜变量,其分布是均值和方差为c和n的高斯混合变量。基于平均场理论[137],GMVAE因子\(p(x,z,n,c)=p(x|z)p(z|n,c)p(n)p(c)\)作为后验代理。同样,将这些变分因子用神经网络参数化,并优化了ELBO损失。

潜在树VAE(LTVAE,latent

tree

VAE)[80]基于GMM和VAE,应用潜在树模型[138]进行表示学习和结构学习进行聚类。不同的是,LTVAE有一个VAE的变体,具有潜在变量的上层结构。上层结构是在潜在特征之上的离散潜在变量的树形结构。所有变量之间的连通性结构被定义为通过消息传递[139]进行优化的潜在树模型的潜在结构。

一些深度生成聚类方法的成功取决于良好的初始预训练。例如,在VaDE

[77]中,需要进行预训练来初始化集群质心。在通过图嵌入(DGG,graph

embedding)[140]的GMVAE的DC中,需要预训练来初始化图嵌入。虽然GMVAE

[78]共同学习先验和后验参数,但每个类的先验都依赖于一个随机变量,而不是类本身,这似乎是违反直觉的。基于GMVAE和VaDE的思想,Prasad等人[82]为了解决他们的谬误,提出了一种利用VAE进行图像聚类(VAEIC,VAE

for image

clustering)的新模型。与上述方法不同的是,VAEIC的先验参数是确定性的,并且先验参数和后验参数是联合学习的,而不需要进行预训练过程。不是像GMVAE和VaDE那样执行贝叶斯分类,VAEIC采用更直接的推理和更有原则的潜在空间先验,从而得到更简单的推理模型\(p(x,z,c)=p(x|z)p(z|c)p(c)\)和更简单的近似后验\(q(z,c|x)=q(c|x)q(z|x,c)\)。聚类分配由\(q(c|z)\)直接预测。此外,作者采用数据增强,设计了图像增强损失,使模型具有鲁棒性。

除了上面提到的基于VAE的DC方法外,Figueroa和Rivera

[79]使用连续的Gumbel-Softmax分布[141],[142]来近似分类分布进行聚类。[81]等人扩展了变分阶梯自动编码器[143],并提出了一种解纠缠聚类算法。Cao等人[83]提出了一种简单、可扩展、稳定的变分DC算法,该算法引入了对变分DC的通用改进。

D. 基于GAN

E. 基于GNN

IV. 半监督的深度聚类

传统的半监督学习可分为三类:半监督分类[170]、[171]、半监督降维[172]、[173]和半监督聚类[13]、[174]、[175]。通常,无监督数据的约束被标记为“必须链接”和“不能链接”。具有“必须链接”约束的样本属于同一个集群,而具有“不能链接”约束的样本属于不同的集群。大多数半监督聚类目标是无监督聚类损失和约束损失的结合。

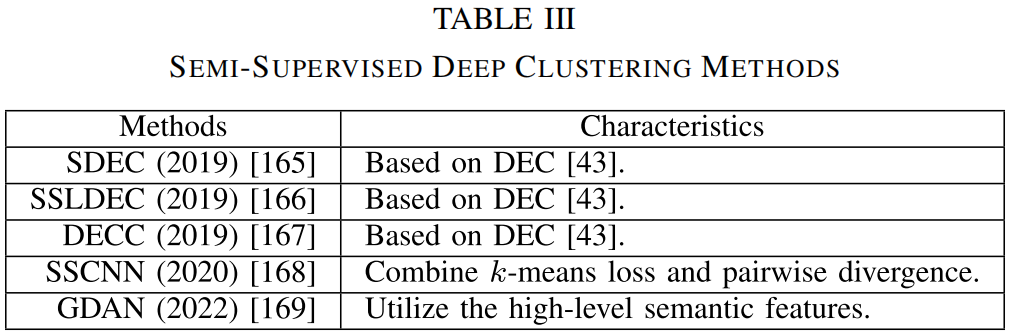

半监督深度聚类技术还没有得到很好的研究。在这里,我们介绍了几个具有代表性的方法。这些工作使用不同的方法将关系约束和神经网络相结合,以获得更好的聚类性能。我们在表三中总结了这些方法。

半监督DEC(SDEC)[165]是基于DEC

[43]的,并在特征学习过程中加入了成对约束。其损失函数被定义为 \[\operatorname{Loss}=\operatorname{KL}(S\|R)+\lambda{\frac{1}{n}}\sum_{i=1}^{n}\sum_{k=1}^{n}a_{i

j}\left\|z_{i}-z_{j}\right\|^{2}\]

其中,λ是一个权衡参数。如果\(x_i\)和\(x_j\)被分配给同一集群,则\(a_{i j} = 1\),如果\(x_i\)和\(x_j\)满足不能链接约束,则\(a_{i j} = -1\),否则\(a_{i j} =

0\)。如损失函数所示,它由两部分组成。第一部分是KL散度损失,在第三-A节中解释。第二部分是半监督损失,表示嵌入式特征\(\{z_{i}\}_{i=1}^{n}\)与参数\(a_{i j}\)之间的一致性。直观地说,如果\(a_{i j} = 1\),为了最小化损失函数,\(\|z_{i}-z_{j}\|^{2}\)应该很小。相比之下,如果\(a_{i j} = -1\),为了最小化损失,\(\|z_{i}-z_{j}\|^{2}\)应该很大,这意味着zi与zj在潜在空间Z中是分开的。

和SDEC一样,大多数半监督直流方法都是基于无监督直流方法的。通过增加半监督损失,可以直接将无监督直流方法扩展为半监督直流方法。与无监督直流方法相比,数据中额外的半监督信息可以帮助神经网络提取更适合聚类的特征。也有一些工作集中于将现有的半监督聚类方法扩展到深度学习版本。例如,基于DEC(SSLDEC)的半监督学习和深度约束聚类(DECC)[167]的特征提取过程都是基于DEC的。他们的训练过程类似于半监督的k-means

[174],它通过交替使用已标记和未标记的数据样本来学习特征表示。在训练过程中,算法使用标记样本来保持模型的一致性,并选择高度置信度的未标记样本作为新标记样本来调整网络。基于神经网络[168]的半监督聚类结合了k-means损失和成对散度,同时学习聚类中心以及语义上有意义的特征表示。GDAN

[169]利用实例识别准则,通过借口任务获取域不变特征。随后,GDAN通过语义邻居聚类,专门关注高级语义特征,对齐这两个领域。

V. DEEP MVC

上述深度聚类方法只能处理单视图数据。在实际的聚类任务中,输入数据通常有多个视图。例如,同一主题的报告可以用不同的语言来表达,同一只狗可以用相机从不同的角度捕捉到,相同的单词可以用不同的书写风格的人来书写。提出了MVC方法[18],[176],[177],[178],[179],[180],[181],[182],[183],[184],[185],利用多个视图之间的互补信息来提高聚类性能。

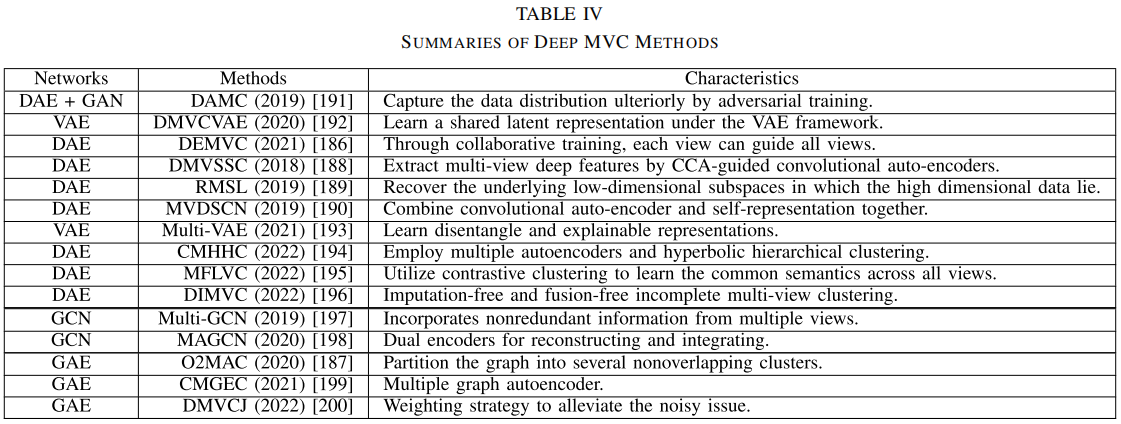

近年来,深度学习在MVC中的应用一直是[186]、[187]、[188]、[189]、[190]等领域的热点。这些深度MVC算法专注于解决具有不同形式的输入数据的聚类问题。由于这些方法中使用的网络结构都是自编码器,因此我们根据采用的聚类理论基础将其分为三类:基于dec、基于子空间聚类和基于gnn。它们汇总见表四。

A. 基于DEC

B. 基于子空间聚类

C. 基于GNN的

VI. 基于迁移学习的深度聚类

迁移学习已经成为一种新的学习框架,以解决训练和测试数据来自不同的特征空间或分布[225]的问题。对于复杂的数据,如有噪声视频的高分辨率真实图片,传统的聚类方法即使是深度聚类方法都不能很好地工作,因为特征空间的高维性,没有统一的标准来保证聚类过程。迁移学习通过传输信息为这些问题提供了新的解决方案,这些信息从源域获得附加信息,以指导目标域的聚类过程。在早期,深度域自适应的思想简单而清晰,如利用源域分类损失的深度重构-分类网络和目标域重构分类损失(DRCNs)[226]。这两个域共享相同的特征提取器。随着DNN的发展,我们现在有了更先进的知识转移方法。

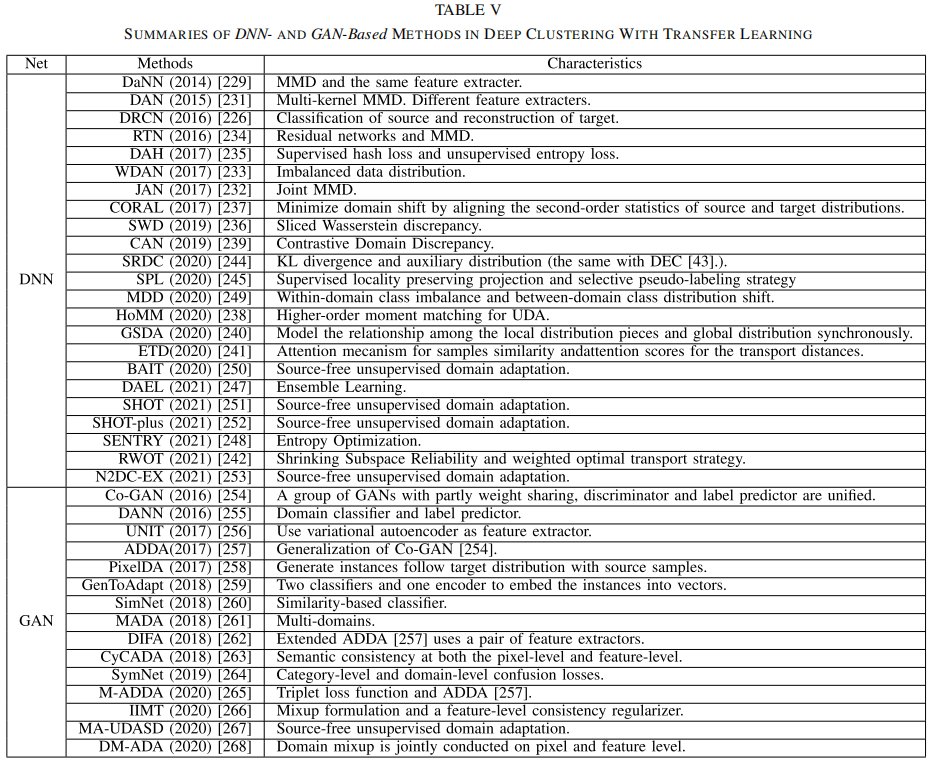

在本节中,我们将介绍一些关于聚类的迁移学习工作,它被分为两部分。第一部分是“基于DNN的”,第二部分是“基于gan的”。它们总结在表V中。

A. 基于DNN

B. 基于GAN

VII. 深度聚类的未来发展方向

基于上述文献的综述和分析,DC已被应用于几个领域,我们重视几个值得进一步研究的方面。

理论探索:

虽然通过针对特定问题的解决需求设计更复杂的深度聚类方法,已经实现了显著的聚类性能,但对于如何定性分析特征提取和聚类损失对最终聚类的影响,目前还没有可靠的理论分析。因此,探索深度聚类优化的理论基础,对指导该领域的进一步研究具有重要意义。深度聚类:

由于大量数据带来的复杂性,大多数现有的深度聚类模型都是为特定的数据集设计的。来自不同来源和形式的复杂数据给聚类带来了更多的不确定性和挑战。目前,需要深度学习和图学习来解决复杂的数据处理问题。

模型效率:

深度聚类算法需要大量的样本来进行训练。因此,在小样本数据集中,DC容易发生过拟合,这导致聚类效应降低,模型的泛化性能降低。另一方面,具有大规模数据的深度聚类算法具有较高的计算复杂度,因此可以采用模型结构优化和模型压缩技术,以减少模型的计算负荷,并在实际应用条件下提高效率。

多视图数据融合:

在实际应用场景中,聚类通常不仅使用单个图像信息,还使用可用的文本和语音信息。然而,目前大多数深度聚类算法只能使用一种信息,不能很好地利用现有的信息。后续的研究可以考虑充分整合两个或两个以上视图的信息,充分利用不同视图数据的一致性和互补性,以提高聚类效果。此外,如何在过滤噪声的同时结合不同视图的特征,以确保更好的视图质量还需要解决。

基于图学习的深度聚类:

在现实中,大量的数据集以图结构的形式存储。图结构可以表示样本点之间的结构关联信息。如何有效地利用结构性信息对于提高聚类性能尤为重要。无论是单视图深度聚类还是多视图深度聚类的广泛应用,现有的基于图学习的聚类方法仍然存在一些问题,如图结构信息没有得到充分利用,不同视图的差异和重要性。因此,对复杂图结构信息的有效分析,特别是合理利用图结构信息来完成聚类任务,还需要进一步的探索。

VIII. 深度聚类方法的总结

本文介绍了深度聚类领域的最新研究进展。这主要是一种数据结构:单视图、半监督、多视图和迁移学习。单视图方法是我们调查中最重要的部分,它继承了传统聚类方法的问题设置。我们系统地区分了具有数据源的聚类方法,并根据其所基于的网络进一步介绍了它们。在这些网络中,基于DAE的方法和基于DNN的方法较早被提出,但可能由于其在真实数据集上的性能较差而受到限制。与基于DAE和基于DNN的方法相比,基于VAE和基于GAN的方法近年来因其强大的特征提取和样本生成能力而备受关注。图神经网络是近年来最受欢迎的网络之一,特别是在社区发现问题中。因此,我们也总结了基于GNN的聚类方法。随着互联网的发展,聚类数据存在不同的应用场景,因此我们总结了一些存在不同问题设置的聚类方法。半监督聚类方法用约束来聚类数据,这些约束可以通过添加约束损失从单视图聚类方法中发展出来。多视图聚类方法使用不同视图的信息作为补充。它已被广泛地应用于传统的神经网络和图神经网络中。迁移学习可以将已标记域的知识转移到未标记域。我们介绍了基于迁移学习的两种类型网络的聚类方法: DNN和GAN。基于DNN的方法侧重于两个领域的测量策略,而基于GAN的方法使用鉴别器来拟合测量策略。大多数深度聚类方法的复杂性可以随着数据大小n的线性扩展,使其适合于大规模的现实应用,如社交网络、生物信息学和电子商务。