FaceReclaim

FaceReclaim: Deep Traceability of Face-Swapped Images Through Feature Decoupling

摘要

换脸技术(Deepfake)能够实现人脸替换,同时保留被替换者原有的面部特征(如表情和姿势)。尽管该技术应用广泛,但其滥用可能引发重大安全隐患。近年来,学界提出了多种基于二元分类模型的深度伪造取证技术来验证图像真实性。然而,另一个关键问题——如何在换脸过程中追踪被替换者的原始面容——却鲜少受到关注,因为这看似天方夜谭。本研究聚焦于“换脸深度伪造可追溯性”(TFD)这一课题。与现有深度伪造检测任务不同,TFD致力于恢复换脸过程中丢失的原始人脸信息。具体而言,我们将TFD重新定义为一种特殊的图像间编辑问题,并提出名为FaceReclaim的新型扩散框架来实现TFD。为确保有效溯源,我们开发了多尺度人脸属性解耦(FAD)和多模态人脸身份提示(FIP)作为双重条件引导机制。FAD从合成换脸图像中提取多尺度属性信息,解耦出关键特征,为修复过程提供积极指导以保留核心属性特征。FIP整合文本与视觉指令作为负向引导,明确指示模型如何擦除换脸图像中的身份痕迹。研究表明,合成人脸仍能保留原脸细微可辨的特征,从而实现精准还原。我们从视觉修复效果和人脸验证两个维度对模型进行评估,大量实验数据充分证明了该方案在定性与定量层面的有效性。

提出的方法

本节将详细介绍我们提出的FaceReclaim框架。如图2所示,该框架包含三大核心模块:1)多尺度面部属性解耦(FAD),通过提取结果人脸的多尺度属性信息提供正向引导,确保面部特征的完整性;2)多模态身份提示(FIP),通过整合纹理与视觉指令编码,明确指导模型从结果人脸中移除原始身份信息;3)扩散式面部重建(FRD),作为条件生成式主干网络,通过双条件引导的扩散过程实现目标人脸的精准重建。

.png)

图2.FaceReclaim模型的架构框架。该架构包含三大核心模块:(1)面部属性解耦模块,通过FAD网络从结果人脸中提取多尺度属性表征(MAR);(2)面部身份提示网络,借助FIP网络整合文本与视觉信息生成多模态身份提示;(3)扩散式面部重建模块,采用扩散过程结合属性网络和身份提示双重引导实现目标人脸重建。本流程的详细说明详见第三节开头部分。

在训练过程中,我们假设能够获取人脸交换三元组的全部三个组件:源脸、目标脸和结果脸。首先将目标脸编码为潜在表征,通过扩散过程逐步添加噪声。与此同时,结果脸通过FAD模块(正向引导)提供多尺度属性特征,而源脸则由FIP模块生成多模态身份提示(负向引导)。经过噪声处理的目标潜在表征与结果脸潜在表征被拼接后,输入基于UNet的去噪网络,在FAD和FIP的共同条件下学习恢复目标脸。推理阶段不使用目标脸,训练时使用的潜在噪声特征被替换为高斯噪声,并仅依赖结果脸(用于FAD)及可选源脸(用于FIP)来指导重建过程。

A.FAD网络设计

换脸Deepfake的目标是将源人脸的身份转移到目标人脸,同时保留目标的特征。结果与目标特征之间的强相关性使得结果人脸的特征成为指导修复过程的关键资源。

根据结果人脸Iresult的特征,我们假设其潜在表征包含两个关键组成部分:身份相关特征S(主要继承自源人脸)和属性相关特征A(反映表情、姿态等源自目标人脸的非身份特征)。这两个组成部分近似满足解耦约束与互补约束,具体表述如下

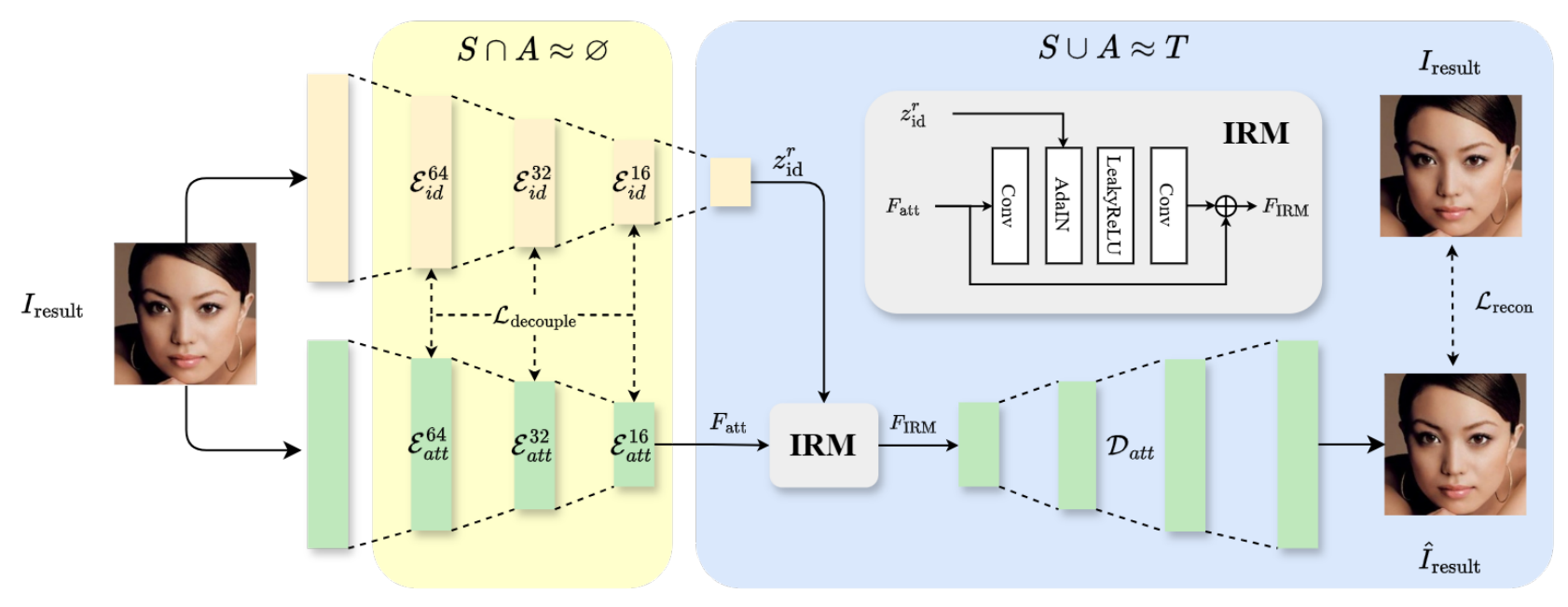

其中T表示结果人脸的完整面部特征表示。这里,I(S;A)是S和A之间的互信息,其最小化以促进独立性;H(S,A)是它们的联合熵,应与T的熵值相匹配以确保信息不丢失。这些约束条件确保身份特征与属性特征既相互独立又共同构成完整的面部表征。本研究提出了一种FAD网络来解耦结果人脸中的多尺度属性信息。由此产生的多尺度属性表示(MARs)将作为先验知识引导修复过程。如图3所示,我们的FAD架构采用双编码器设计:

图3.所提人脸属性解耦(FAD)网络的概述。身份编码器和属性编码器通过解耦损失强制提取互斥特征。身份重建模块(IRM)动态整合这些特征,并通过解码器精准重建原始人脸,同时保留关键的身份与属性信息。

- 身份编码器Eid:一个预训练并冻结的人脸识别网络[36],用于提取身份信息S。

- 属性编码器Eatt:一种通过逐步下采样Iresult来提取多尺度属性特征A的卷积网络。采用解耦损失函数,可显式引导Eatt排除身份相关特征。

- 确保解耦约束:为满足I(S;A)≈0的条件,身份编码器与属性编码器需要学习具有最小重叠的表征。我们通过解耦损失实现这一目标,该损失在多个尺度上惩罚身份特征与属性特征之间的相关性。具体而言,对于每个尺度k,我们计算Eid和Eatt特征图之间的余弦相似度。