LSNet:See Large, Focus Small

LSNet: See Large, Focus Small

Ao Wang1 Hui Chen2* Zijia Lin1 Jungong Han3 Guiguang Ding1

1清华大学软件学院

2清华大学BNRist

3清华大学自动化系

摘要

视觉网络设计,包括卷积神经网络和视觉变换器,显著推动了计算机视觉领域的发展。然而,其复杂的计算过程给实际应用带来了挑战,特别是在实时场景中。为解决这一问题,研究人员探索了多种轻量级高效网络架构。但现有轻量模型主要依赖自注意力机制和卷积操作进行特征融合,这种过度依赖导致轻量网络在感知与聚合过程中效率受限,在计算资源有限的情况下难以实现性能与效率的平衡。本文从高效人类视觉系统中固有的动态异尺度视觉能力中获得启发,提出一种“广域感知+局部聚焦”的轻量级视觉网络设计策略。我们创新性地引入LS(Large-Small)卷积结构,该结构融合了大核感知与小核聚合特性。这种设计能高效捕捉多维度感知信息,并对动态复杂视觉表征实现精准特征聚合,从而实现视觉信息的高效处理。基于LS卷积架构,我们提出了LSNet这一全新轻量级模型家族。大量实验表明,LSNet在多种视觉任务中展现出比现有轻量级网络更优的性能和效率。相关代码和模型可在https: //github.com/jameslahm/lsnet获取。

1. 引言

视觉网络设计始终是计算机视觉领域的研究热点[17,22,24,50,51,96]。其中,卷积神经网络(CNN)[24,29,38,39,51]和视觉变换器(ViTs)[17,50,63,74,88,93]两大主流架构,在各类计算机视觉任务中不断突破边界[3,4,23,70,82,84,92]。然而,这两种架构在传统计算上都存在显著瓶颈,给实际应用带来巨大挑战——特别是在实时场景中,其性能表现尤为突出[44,49]。

近期,科研人员正致力于探索视觉网络的轻量化与高效化设计[7,34,55,57,60,76]以满足实际应用需求。尽管这些轻量级模型效果显著,但其底层架构仍需依赖自注意力机制[17,77,86]和卷积层[38,39]等基础模块来实现特征融合技术。这种对基础模块的过度依赖,往往会影响网络感知与聚合过程的效率与效果,导致架构表达能力受限或推理速度下降。

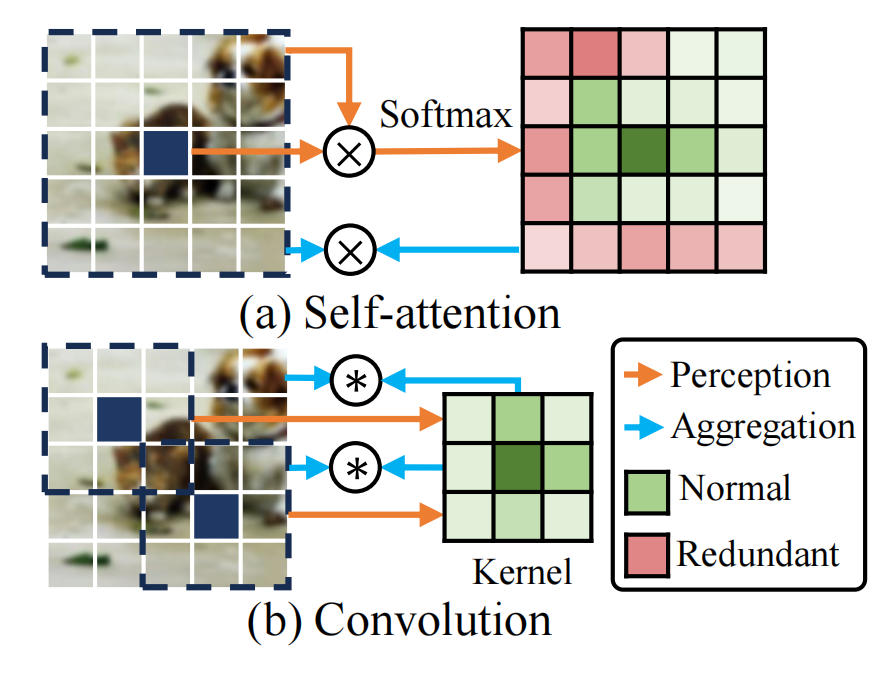

本质上,上下文感知与特征聚合是实现标记混合的核心机制[19,73,91],能够有效促进空间信息融合。感知模型通过分析标记间的上下文关联,而聚合机制则基于这些关联整合特征。在现有的轻量级模型中,两种主流的标记混合方法——自注意力机制和卷积网络——分别采用不同的感知与聚合方式。具体而言,自注意力机制通过全局特征交互实现整体感知,并借助特征加权求和完成特征聚合。卷积方法通过感知标记之间的相对位置关系,并使用静态核权重聚合特征。然而,如图1(a)和(b)所示,这两种方法都存在局限性。

(1)自注意力机制容易对缺乏显著连接的区域过度关注,导致关键信息的聚合效果降低,例如在信息量较少的背景[46,65]中。此外,其感知与聚合过程共享相同的混合范围。自注意力机制及其变体在扩展上下文时,[19,33,49]会显著增加计算复杂度。这种特性使得轻量级模型难以在有限的计算资源下实现高表征能力。

(2)在卷积神经网络中,感知模型所建模的标记间关系(即聚合权重)由固定核权重决定。因此,尽管卷积网络效率高,但对上下文邻域的变化缺乏敏感性。这给轻量级模型的表达能力带来了限制,特别是考虑到这类网络本身存在固有局限性。在此背景下,探索一种能在有限计算成本下实现更高效感知与聚合处理的轻量级模型特征融合方案显得尤为重要。

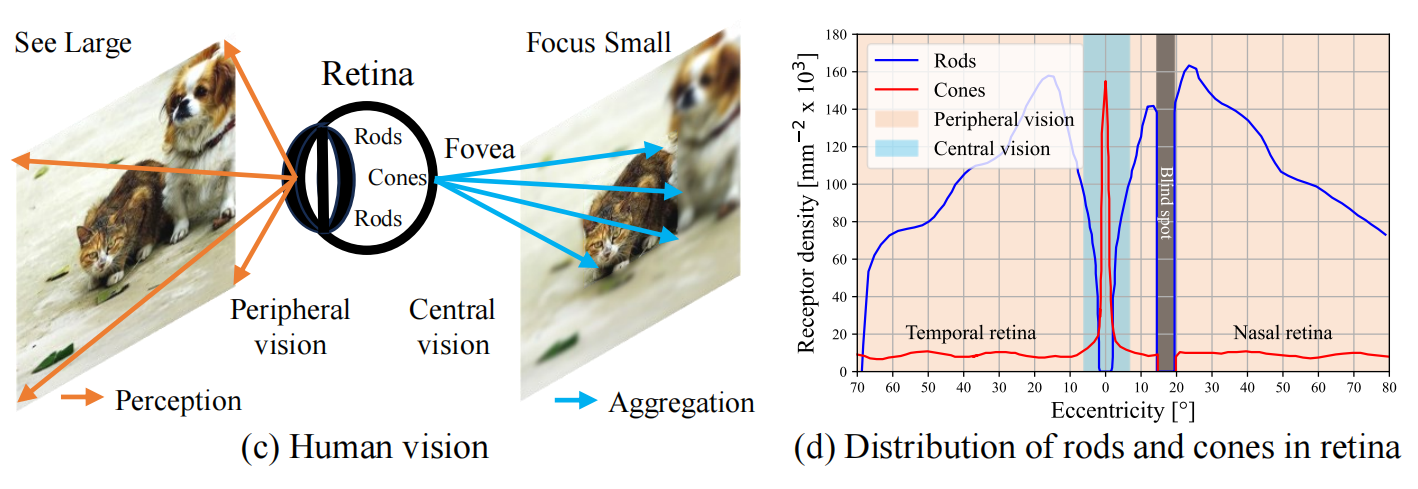

为此,我们首先对感知和聚合过程背后的直觉进行了彻底的检验。我们发现,它们与高效人类视觉系统中的动态异尺度视觉能力现象高度吻合。

具体来说,如图1(c)所示,人类视觉系统遵循双阶段机制:

(1)首先通过周边视觉的大视野感知[62,69]捕捉场景的宏观概览,即“看大”;

(2)随后将注意力转向场景中的特定元素,借助中央视觉的小视野聚合能力[59,69]实现细节理解,即“聚焦小”。

这种视觉特性源于视网膜[36,62]中两种感光细胞——杆状细胞和锥状细胞——独特的空间分布与视觉能力,如图1(d)所示。杆状细胞广泛分布于视网膜边缘区域[59],生成的图像相对模糊且空间细节有限[78]。不过它们能对可见光谱产生广泛响应,与视网膜边缘的锥状细胞协同工作,共同实现大视野周边视觉能力[72],从而让人“看清楚全局”。而锥状细胞则主要集中在中央凹区域,这个小范围负责中央视觉功能[87]。黄斑区密集分布着视锥细胞,这些细胞构成了捕捉精细细节和复杂特征的最敏锐区域[35,75,78],从而实现“聚焦微小”。在周边感光细胞高效的大视野感知引导下,黄斑区能够通过小范围集中聚焦,精准捕捉细微特征的影像[62]。这种“放眼全局,聚焦细节”的方法使人类视觉系统能够快速有效地处理视觉信息[78],从而促进准确和高效的视觉理解。

这些研究需求促使我们设计出既能感知大范围视觉场景又能整合局部细节的高效视觉网络。为此,我们首创了“大-小”(LS,Large-Small)卷积运算机制,该机制模拟人类视觉系统中“广角捕捉+微距聚焦”的核心策略,从而有效提取具有区分度的视觉特征模式。LS卷积通常采用大核静态卷积实现大视野感知,小核动态卷积用于小视野聚合。该方法并非简单叠加两种卷积方式,而是通过大核深度卷积捕捉广泛上下文信息来建模空间关系。随后,基于这些参数构建具有群组机制的小核动态卷积操作,从而在高度相关的视觉域内实现特征融合。通过这种方式,大核静态卷积能有效捕捉扩展的邻域信息,从而提升关系建模能力,类似于周边视觉系统。此外,得益于这一特性,小核动态卷积可自适应地整合微小环境中的复杂视觉特征,实现精细的视觉理解,如同中心视觉系统般精准。与此同时,我们巧妙地结合深度卷积与分组机制,对LS卷积进行了高效设计。聚合范围被限制在一个小区域内。这种设计有效确保了感知和聚合过程的低复杂度。因此,我们的LS卷积在性能和效率之间取得平衡,使得轻量级模型能够在低计算成本下充分发挥表征能力。

我们将LS卷积视为标记混合的核心运算单元,并将其与其他主流架构设计相结合,构建出LS模块。在此基础上,我们提出了一类新型轻量级模型——LSNet。大量实验表明,在多种视觉任务中,LSNet相比现有最先进轻量级模型展现出更优的性能和效率[11,47,99]。我们期待LSNet能成为强有力的基准模型,为轻量化高效模型领域的发展注入新动力。

2. 相关工作

Efficient

CNNs.

过去十年间,卷积神经网络(CNN)已成为各类视觉任务的基础架构[2,15,16,52,66,79]。为提升实际应用效果,研究者们投入大量精力设计轻量级高效网络[12,13,30,31,53,71,81]。例如,MobileNet

[31]和Xception [8]采用深度可分离卷积架构。MobileNetV2

[67]通过引入带线性瓶颈的反向残差块来提升效率。ShuffleNet

[98]和ShuffleNetV2

[53]则结合通道混洗与通道分割操作以增强组信息交互。针对硬件特性,研究者还探索了硬件感知神经架构搜索(NAS)以获得紧凑型视觉网络[30,71]。同时,考虑到有限的感受野范围,部分研究致力于增强轻量CNN对长程依赖关系的建模能力[34,61,95]。例如,ParC-Net

[95]引入位置感知循环卷积以实现全局感受野,AFFNet

[34]则通过循环填充实现全局卷积的自适应频率滤波。

Efficient

ViTs.

自VisionTransformer[17]问世以来,基于Transformer架构在计算机视觉领域迅速崛起。ViTs

已成功应用于多种视觉任务,并展现出卓越性能[18,97]。与此同时,研究者们不断优化其效率,开发出适用于实际部署的轻量级ViTs模型[44,58,76,80]。例如,MobileViT

[57]通过融合MobileNet模块与MHSA模块,构建出混合架构;EdgeViT

[60]创新性地将自注意力机制与卷积运算相结合,实现了成本效益型信息交互;为缓解推理瓶颈,EfficientFormer

[44]提出维度一致性设计范式,有效平衡了延迟与性能的权衡关系;而FastViT

[76]则通过结构化参数重配置和大核卷积技术,进一步提升了混合ViTs的性能表现。

Efficient Token

Mixing.

CNN和ViT分别采用不同的特征混合方式,即卷积与自注意力机制,并结合独特的感知与聚合过程。基于这些方法,为开发轻量级视觉网络,研究者探索了多种高效的空间信息交互特征混合方式。例如:卷积层方面,反卷积[41]通过多层感知机(MLP)获取单像素条件下的聚合权重;CondConv

[90]提出基于全局上下文的逐例路由策略,实现多卷积核的线性组合;自注意力机制中,EdgeNeXt

[55]创新性地采用分层深度转置注意力(SDTA)混合多尺度特征;PVTv2

[85]通过线性空间归一化注意力(LSRA,linear spatial reduction

attention)实现注意力层的线性计算复杂度;而EfficientViT

[49]则设计了级联群注意力机制,显著提升网络性能。

3. 方法

3.1.重新审视自注意力和卷积

自注意力机制与卷积操作是现有轻量级网络中用于建模视觉特征的两种主流标记混合方法[93]。对于输入图像,其特征图\(X\in{\mathbb R}^{H\times W\times C}\)(其中H×W表示空间分辨率,C为通道数),标记混合通过以下方式,基于上下文区域\(\mathcal N(x_i)\),为每个标记\(x_i\in{\mathbb R}^C\)生成特征表示\(y_i\in{\mathbb R}^C\): \[y_i={\mathcal A}({\mathcal P}(x_i,{\mathcal N}(x_i)),{\mathcal N}(x_i))\] 其中,\({\mathcal P}\)表示感知,涉及提取上下文信息并捕捉标记之间的关系;\({\mathcal A}\)表示聚合,基于感知结果整合特征,并允许整合来自其他标记的信息。

在自注意力机制中,感知层\({\mathcal P}_{attn}\)通过softmax归一化后的成对相关性计算\(x_i\)与X之间的注意力分数。聚合层\({\mathcal A}_{attn}\)则根据这些注意力分数对X的特征进行加权处理,最终得到\(y_i\)。如图2(a)所示,整个过程可概括为: \[y_{i}=\mathcal{A}_{a t t n}(\mathcal{P}_{a t t n}(x_{i},X),X)=\mathcal{P}_{a t t n}(x_{i},X)(X W_{v});\]

\[\mathcal{P}_{a t t n}(x_{i},X)=\mathrm{sofmax}((x_{i}W_{q})(X W_{k})^{T}),\]

其中Wq、Wk和Wv是投影矩阵。可以观察到,\(\mathcal{P}_{a t t n}\)和\(\mathcal{A}_{a t t n}\)在信息量较少的区域[46,65]中存在冗余注意力机制和过度聚合现象,这限制了轻量级模型的效能。此外,它们对xi采用相同的上下文尺度进行操作。这种同尺度特性会导致当混合范围\(\mathcal N(x_i)\)增加时计算复杂度显著上升,在低计算预算下扩展感知上下文面临挑战。因此,现有轻量级模型中的自注意力机制及其变体[19,49]难以在有限计算成本[34]下实现表征能力与效率之间的最佳平衡。

对于卷积核大小为K的情况,上下文区域是围绕xi的K×K邻域,记作\(\mathcal N_K(x_i)\)。感知器\(\mathcal{P}_{c o n v}\)通过计算\(x_i\)与\(\mathcal N_K(x_i)\)之间的相对位置关系,来确定聚合权重。对于每个\(x_j\in\mathcal N_K(x_i)\),其聚合权重是固定卷积核权重\(W_{conv}\)中对应相对位置的数值。聚合层\({\mathcal A}_{conv}\)随后利用权重对\(\mathcal N_K(x_i)\)中的特征进行卷积。如图2(b)所示,整个过程可表述为: \[\begin{aligned}y_{i}&=\mathcal{A}_{c o n v}(\mathcal{D}_{c o n v}(x_{i},\mathcal{N}_{K}(x_{i})),\mathcal{N}_{K}(x_{i})) \\&=\mathcal{P}_{c o n v}(\mathcal{x}_{i},\mathcal{N}_{K}(\mathcal{x}_{i}))\circledast\mathcal{N}_{K}(\mathcal{x}_{i})\\\end{aligned}\]

\[\mathcal{P}_{c o n v}(\mathcal{x}_{i},\mathcal{N}_{K}(\mathcal{x}_{i}))=W_{c o n v},\]

其中\(\circledast\)表示卷积运算。可以观察到,卷积中token的混合范围由核尺寸K决定——对于轻量级模型而言,核尺寸通常较小,这导致感知范围受限。此外,感知\(\mathcal{P}_{c o n v}\)建模的词元间关系(即聚合权重)仅取决于相对位置,因此所有词元共享且固定不变。这种机制阻碍了token对相关上下文的自适应能力,限制了表达潜力。考虑到轻量级网络本身建模能力有限,这种局限性显得尤为突出。

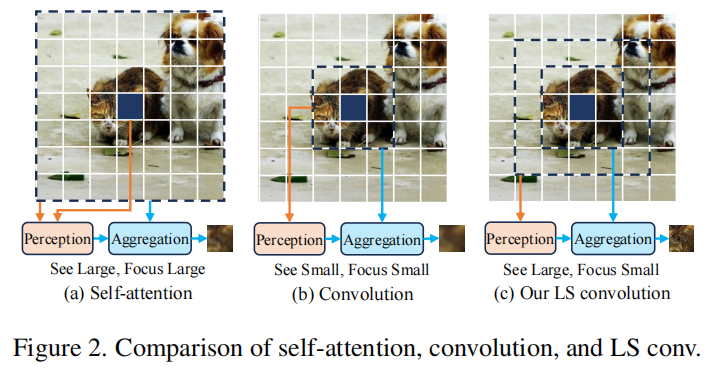

3.2.LS (Large-Small)卷积

受人类视觉系统[59,62,72]展现的动态异尺度视觉能力启发,我们提出了一种名为“大视域聚焦小细节”的创新策略,用于感知与聚合过程,旨在实现轻量级模型中高效且有效的标记混合(如图2(c)所示)。该方法通过大范围感知有效收集全面的上下文信息并建立关系模型,同时借助小范围聚合在高度相关环境中实现精细视觉表征。具体而言,对于标记\(x_i\),其感知上下文区域\(\mathcal{N}_{P}(\mathcal{x}_{i})\)与聚合上下文区域\(\mathcal{N}_{A}(\mathcal{x}_{i})\)的范围存在差异——\(\mathcal{N}_{P}(\mathcal{x}_{i})\)的空间覆盖范围比\(\mathcal{N}_{A}(\mathcal{x}_{i})\)更广,整个过程可表述为:

\[y_{i}=\mathcal{A}(\mathcal{P}(x_{i},\mathcal{N}_{P}(\mathcal{x}_{i})),\mathcal{N}_{A}(\mathcal{x}_{i}));\]

可以观察到:(1)感知模块\(\mathcal{P}\)与聚合模块\(\mathcal{A}\)分别对应不同的上下文范围(即\(\mathcal{N}_{P}(\mathcal{x}_{i})\)和\(\mathcal{N}_{A}(\mathcal{x}_{i})\),这种设计既支持异尺度上下文信息的利用,又能同时捕捉整体环境特征与细节特征。(2)对于空间覆盖范围较大的感知模块,可采用大核深度卷积等成本效益高的操作,从而以最小开销实现感知上下文的扩展。(3)针对邻域较小的聚合模块,我们可采用自适应加权特征求和方法。由于聚合范围有限,该方案既能保证计算效率,又可有效降低运算成本,还能缓解自注意力机制中权重不足的问题。

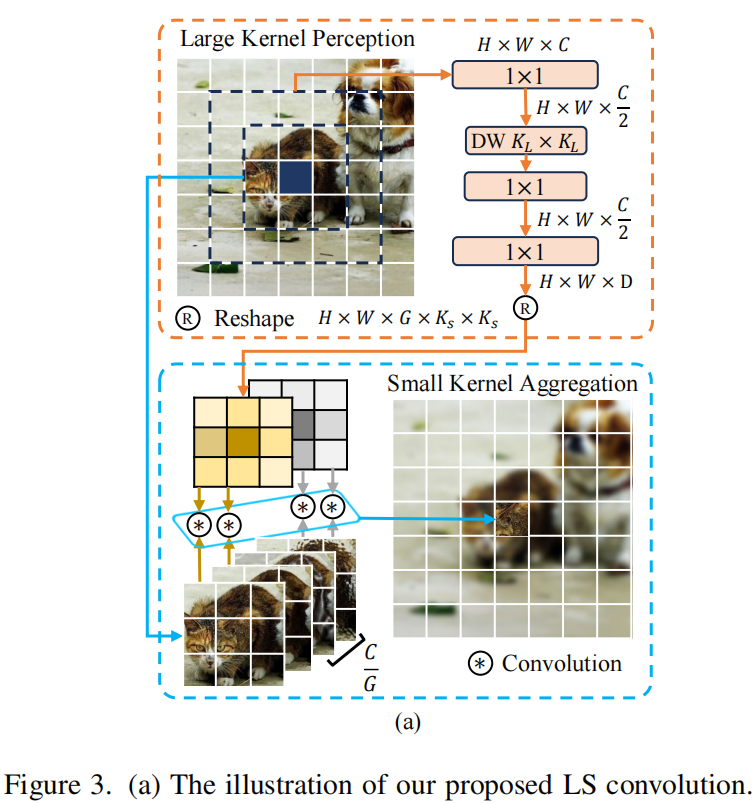

基于这些研究,我们提出了一种新型的LS

(Large-Small)卷积结构。

如图3(a)所示,针对每个标记,该结构引入了两个步骤:

(1)大核感知模型通过大核静态卷积,以扩展的感受野来建模邻域关系。(2)小核聚合模型则通过小核动态卷积,自适应地整合周围特征。

大核感知(LKP,Large-Kernel

Perception)

大核感知采用了大核瓶颈块的设计方案。给定视觉特征图X∈R

H×W×C,我们首先通过逐点卷积(PW)将特征向量投影到较低的通道维度(默认为\(\frac C

2\)),以此降低计算成本,使模型尽可能轻量化。对于xi,我们采用核尺寸为KL×KL的大核深度卷积(DW),以高效捕捉\(\mathcal{N}_{K_L}(\mathcal{x}_{i})\)的广域空间上下文信息,其中\(\mathcal{N}_{K_L}(\mathcal{x}_{i})\)表示以xi为中心、尺寸为KL×KL的邻域区域。这种大核深度卷积能有效扩展感受野,同时以最小成本提升上下文感知能力。随后我们利用逐点卷积(PW)来建模标记间的空间关系,即生成用于聚合步骤的上下文自适应权重W∈R

H×W×D。整个过程可表述为: \[\begin{aligned}w_{i}&={\mathcal P}_{l

s}(x_{i},\mathcal{N}_{K_L}(\mathcal{x}_{i}))\\&={\mathrm

PW}({\mathrm DW}_{K_L\times K_L}({\mathrm

PW}(\mathcal{N}_{K_L}(\mathcal{x}_{i}))))\end{aligned}\]

其中wi∈RD表示为xi生成的权重。

小核聚合(SKA,Small-Kernel

Aggregation)

小核聚合采用分组动态卷积的设计方案。对于视觉特征图X∈R_H×W×C,我们将其通道划分为G个组,每个组包含\(\frac C

G\)个通道,组内通道共享聚合权重,从而降低轻量级模型的内存开销和计算成本。对于每个xi,我们将其对应的权重wi∈R_D(由大核感知生成)重塑为\(w_i^∗\in{\mathbb R}^{G\times K_S\times

K_S}\),其中KS_×KS表示小核尺寸。随后利用wi∗聚合其高度相关的上下文NKS(xi),其中NKS(xi)表示以xi为中心、尺寸为KS_×KS的邻域。具体而言,我们将xi的第c个通道记作xic,该通道属于第g组。通过NKS(xic)与wig∈R_KS×KS的卷积运算,我们获得其聚合特征表示yic。这种方式能有效表征自适应细粒度特征,使模型对多样化上下文中的动态复杂变化保持敏感。整个过程可表述为: