Omni-IML:Towards Unified Image Manipulation Localization

Omni-IML: Towards Unified Image Manipulation Localization

Chenfan Qu,Yiwu Zhong,Fengjun Guo,Lianwen Jin

1华南理工大学

2香港中文大学

3Intsig Information Co.,

Ltd

4华南理工大学

摘要

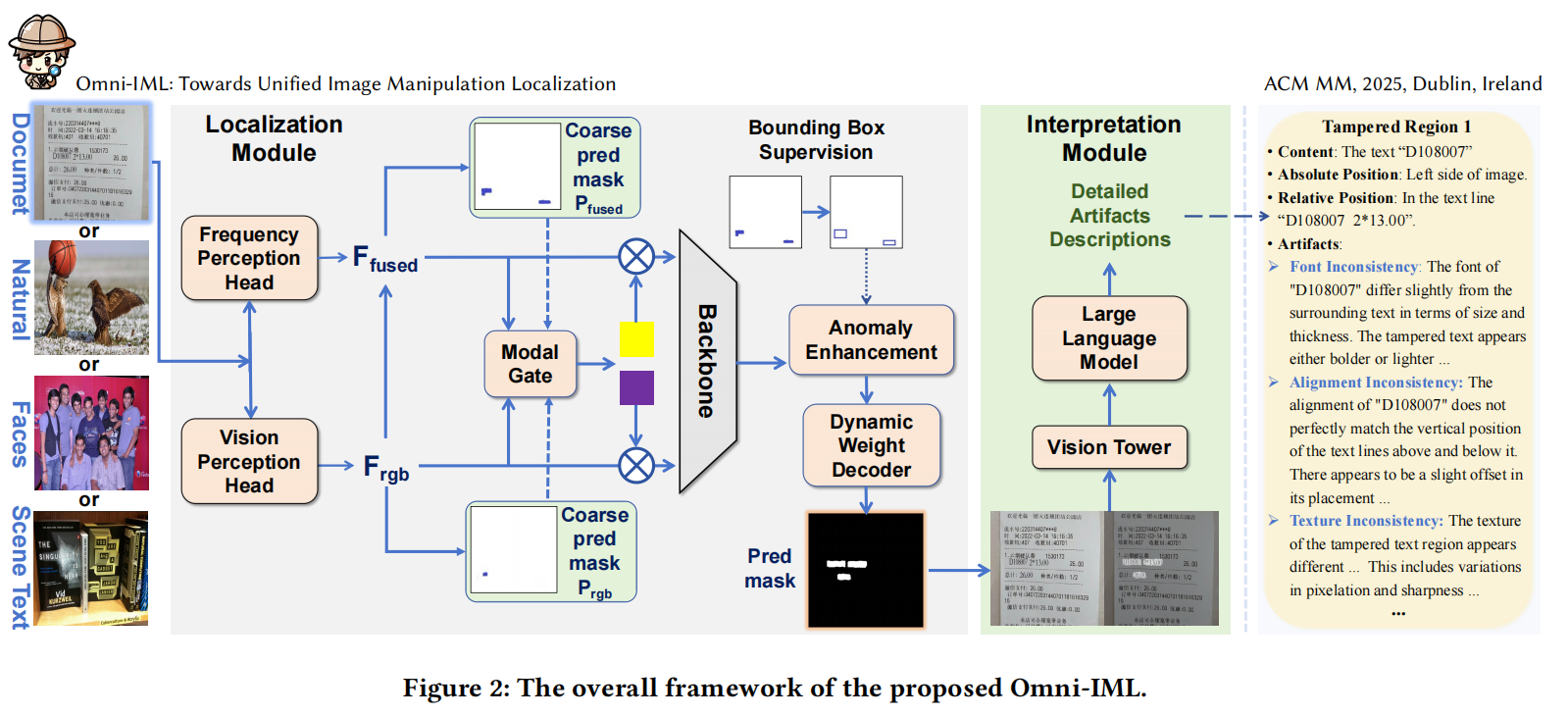

现有的图像处理定位(IML)方法大多依赖特定任务设计,导致其仅在目标IML任务中表现优异。然而当跨多个IML任务进行联合训练时,性能会出现显著下降,严重影响实际应用效果。为此,我们提出Omni-IML——首个旨在统一不同任务IML的通用模型。具体而言,该模型通过三大核心组件实现泛化能力:

(1)模态门编码器,其根据每个样本自适应地选择最佳编码模态,

(2)动态权重解码器,其根据当前任务动态调整解码器滤波器,

(3)一个异常增强模块,利用盒级别的监督来突出篡改区域,并促进任务无关特征的学习。

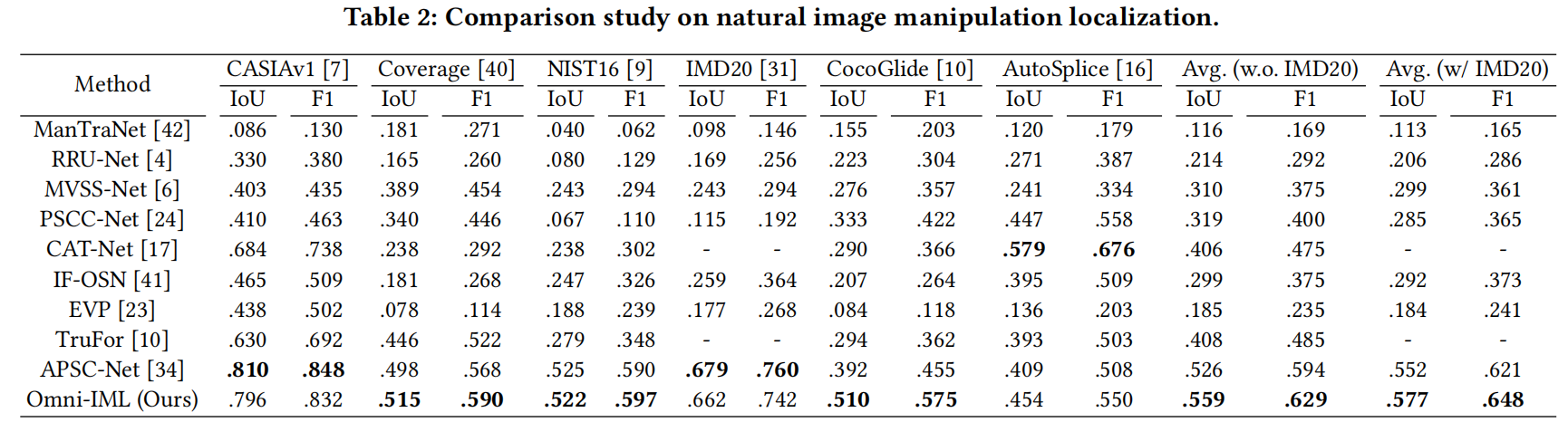

除了定位任务,我们还构建了Omni-273k这一大型高质量数据集,用于辅助篡改图像的解读。该数据集包含对篡改痕迹的自然语言描述,并通过我们自主研发的自动思维链标注技术完成标注。同时,我们设计了一个简洁高效的解释模块,以更好地利用这些描述性注释。大量实验表明,我们的单个模型OmniIML在四大图像取证任务中均取得业界领先表现,不仅为实际应用提供了有效解决方案,更展现了通用型模型在图像取证领域的广阔前景。相关代码和数据集将向公众开放共享。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 喵!

评论

匿名评论