文章总览 - 20

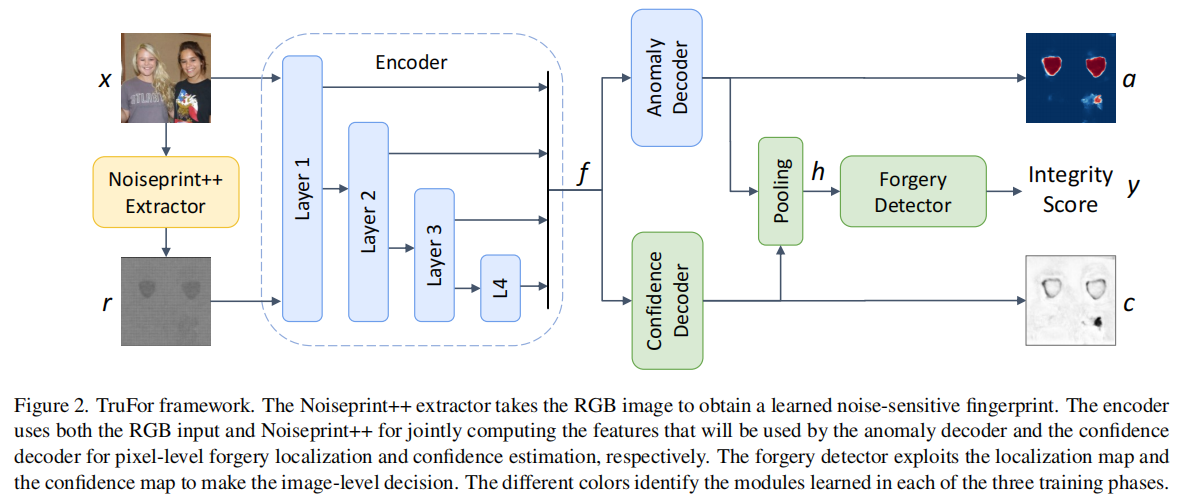

Loupe:A Generalizable and Adaptive Framework for Image Forgery Detection

发表于IJCAI 2025,Loupe通过整合补丁感知分类器与带条件查询的分割模块,实现了全局真实性分类与细粒度掩码预测的同步处理。为增强对测试集分布偏移的鲁棒性,该模型创新性地采用伪标签引导的测试时自适应机制,利用补丁级预测结果对分割头进行监督学习。。

1

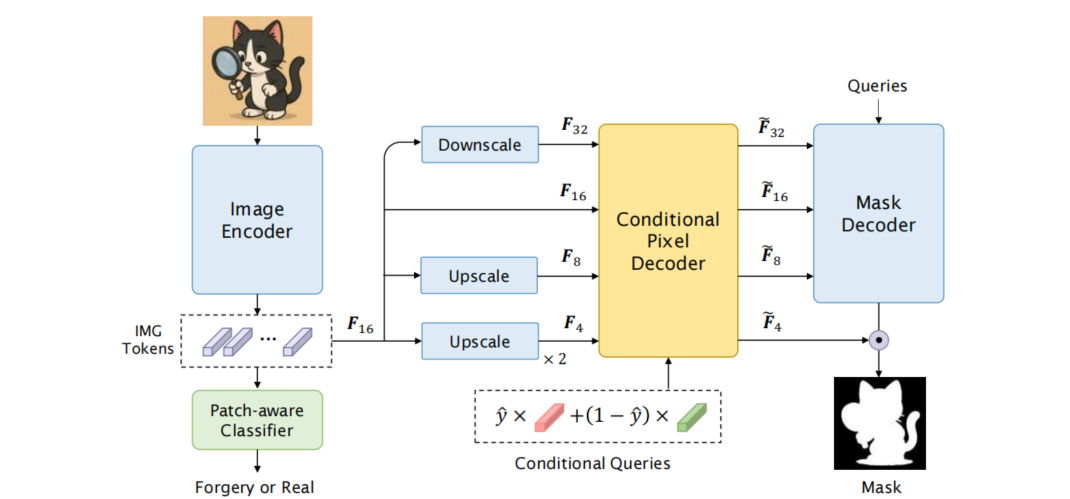

Neural Clustering based Visual Representation Learning

发表于CVPR2024,认为现有图像视觉提取器基于图片是平滑的这一假设设计了基于网格式的架构,因此提出了聚类特征提取FEC,在图像处理中,FEC算法通过两种交替操作实现:首先将像素分组为独立簇以提取抽象特征,随后利用当前特征向量更新像素的深度特征。这种迭代机制通过多层神经网络实现,最终生成的特征向量可直接应用于下游任务。各层间的聚类分配过程可供人工观察验证,使得FEC的前向计算过程完全透明化,并赋予其出色的自适应可解释性。

2

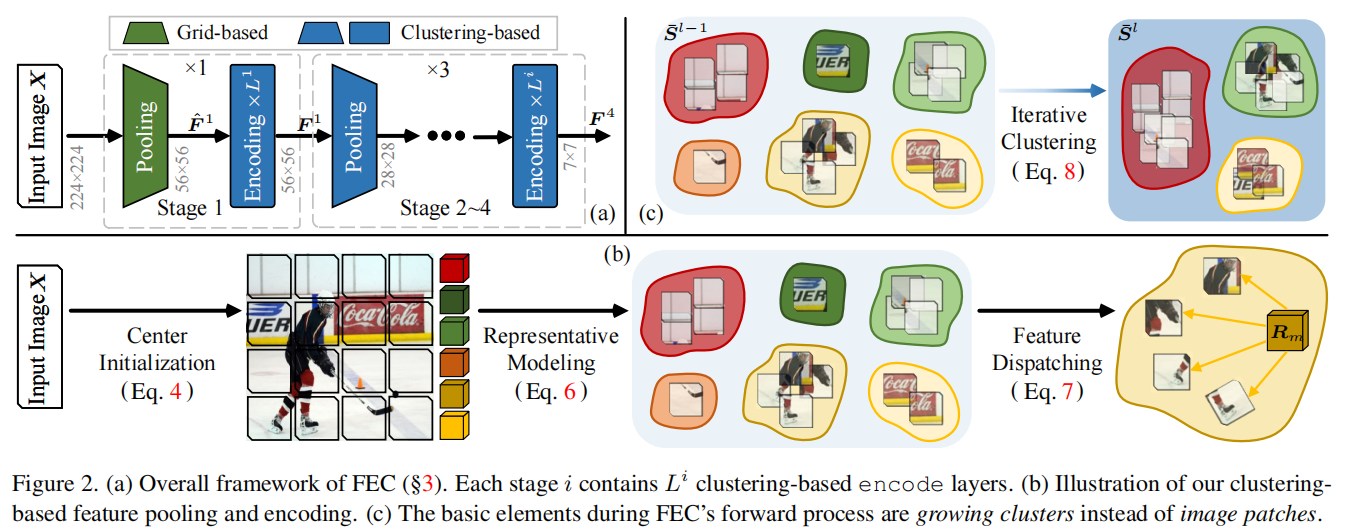

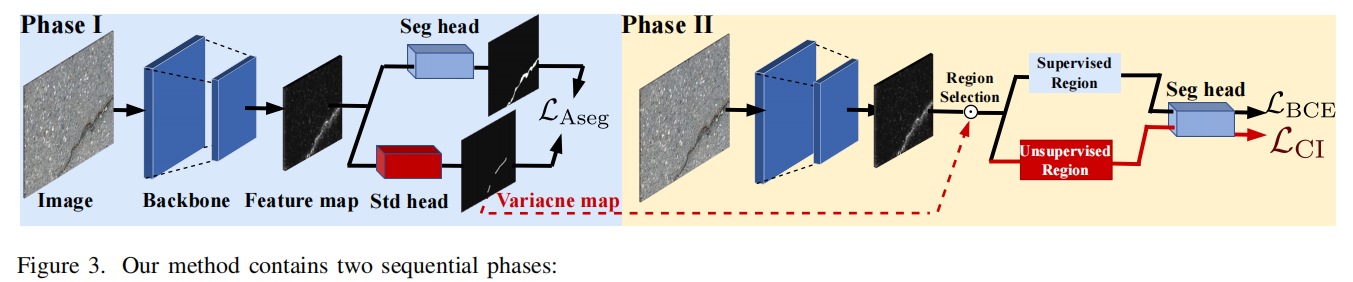

Mind marginal non-crack regions:Clustering-inspired representation learning for crack segmentation

发表于CVPR2024,提出了一种基于聚类启发的表征学习框架,该框架包含自动裂缝分割的双阶段策略。第一阶段通过预处理步骤实现边缘非裂缝区域的精确定位。在第二阶段,为学习这些区域的判别性特征,我们设计了聚类启发式损失(CI Loss,*clustering-inspired loss*),将监督学习模式转变为无监督聚类方式。

3

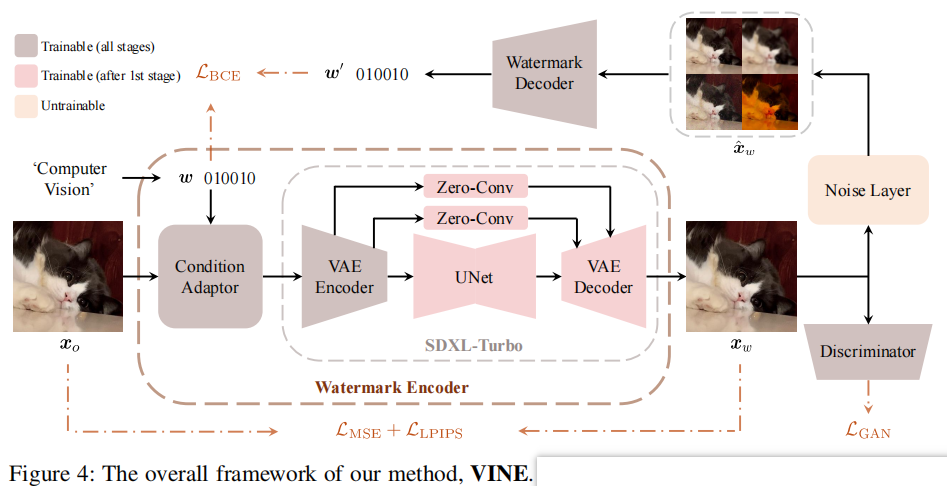

Robust Watermarking Using Generative Priors Against Image Editing:From Benchmarking to Advances

发表于ICLR2025,在本工作中,介绍了W-Bench,这是第一个全面的基准,旨在评估水印方法对广泛的图像编辑技术的鲁棒性,包括图像再生、全局编辑、局部编辑和图像到视频生成。通过实验发现图像编辑一般会消除中高频的信息,所以需要将水印信息保存在低频中

7

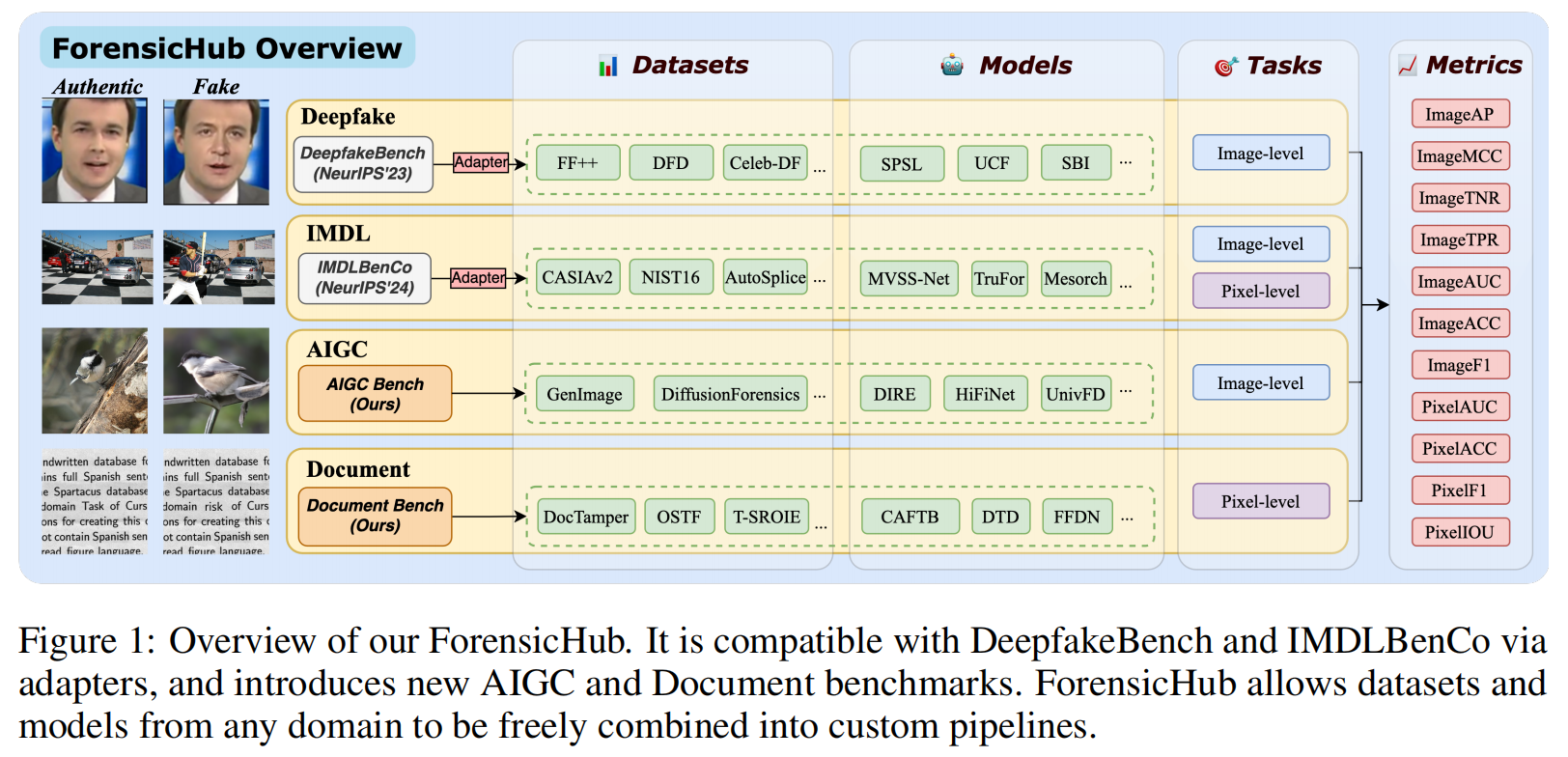

ForensicHub:A Unified Benchmark & Codebase for All-Domain Fake Image Detection and Localization

发表于arxiv上的论文,非常棒的工作!其整合了深度伪造检测、图像篡改检测/定位、AI生成图像检测和文档图像处理定位四大任务,并基于基准实验,提出了独特的发现。

8